Si vous avez déjà travaillé, même brièvement, au sein d’une entreprise, il est probable que vous ayez rencontré la nécessité de rassembler efficacement des informations provenant de diverses sources d’analyse et de données.

Ces analyses de données ont eu un impact majeur sur la génération de revenus et la gestion des dépenses pour de nombreuses organisations. Il n’est pas surprenant de constater la quantité de données créées et traitées, étant donné que leur nombre et leur diversité ne cessent de croître.

Cette expansion incite les entreprises orientées données à adopter des solutions performantes, évolutives et sûres pour l’analyse et la gestion de l’information. Les exigences des systèmes excèdent les capacités des bases de données traditionnelles, c’est là que la technologie du cloud intervient.

Avec les avancées de la technologie cloud actuelle, de nombreuses applications cruciales pour les entreprises, telles que la planification des ressources d’entreprise (ERP), les bases de données et les outils marketing, ont été transférées vers le cloud. Alors que les données commerciales se trouvent désormais dans le cloud, les entreprises ont besoin d’une solution capable de stocker en toute transparence toutes les données provenant de diverses applications basées sur le cloud. Cette solution est l’entrepôt de données cloud.

Cet article a pour but de vous éclairer sur le concept d’entrepôt de données cloud, de vous présenter quelques-uns des meilleurs, et de vous expliquer en conclusion comment choisir celui qui convient le mieux à votre entreprise.

Un bref historique des entrepôts de données cloud

Comme dans tout domaine technique, il est essentiel de comprendre l’origine d’une technologie pour en saisir pleinement le fonctionnement. Cette logique s’applique également à la compréhension du modèle opérationnel d’un entrepôt de données cloud.

Selon Education Ecosystem, les entrepôts de données ont fait leur apparition dans les années 1980, avec pour objectif de faciliter la circulation des données des systèmes d’exploitation vers les systèmes d’aide à la décision (SAD). Les premières versions nécessitaient beaucoup de redondance, et de nombreuses entreprises devaient maintenir plusieurs environnements SAD pour desservir divers utilisateurs. Ces environnements SAD exploitaient les mêmes données, mais leur collecte, leur nettoyage et leur intégration étaient souvent dupliqués.

Au fur et à mesure que les entrepôts de données gagnaient en efficacité, ils sont passés de simples outils de veille stratégique (BI) pour les informations à de vastes architectures analytiques prenant en charge diverses applications, telles que la gestion des performances et l’analyse des performances.

Au fil des années, des progrès considérables ont permis de créer une valeur ajoutée pour les entreprises grâce aux entrepôts de données (EWD) de dernière génération, qui offrent un accès aux données en temps réel et des informations issues de l’apprentissage automatique. Cependant, ce dernier point dépasse le cadre de cet article.

Qu’est-ce qu’un entrepôt de données cloud ?

Si vous souhaitez intégrer l’intelligence dans votre infrastructure d’entreprise, l’entrepôt de données est le cœur de votre architecture. Contrairement aux bases de données classiques, les entrepôts de données sont conçus pour optimiser les requêtes analytiques sur de vastes ensembles de données. Les bases de données, quant à elles, sont souvent des systèmes de traitement transactionnel.

Un entrepôt de données cloud est une base de données accessible en tant que service géré dans un cloud public, optimisé pour la BI et les analyses évolutives. On peut également le considérer comme un ensemble d’informations actuelles et passées.

Bien qu’il existe de nombreux entrepôts de données cloud, chacun propose sa propre combinaison de services. Cependant, certains éléments clés sont communs à toutes ces plateformes : le stockage et la gestion des données, les mises à jour automatiques du logiciel, et une gestion flexible de la capacité qui adapte vos besoins en données de manière transparente.

Principales caractéristiques

- Traitement massivement parallèle (MPP) – Cette fonctionnalité est présente dans les entrepôts de données cloud qui soutiennent les projets de Big Data. Elle permet de bénéficier de requêtes à haute performance lors du traitement de gros volumes de données. Le MPP implique plusieurs serveurs fonctionnant en parallèle pour répartir les charges de traitement, d’entrée et de sortie.

- Stockage de données en colonnes – Cette fonctionnalité offre une flexibilité économique pour la gestion des analyses. Les stockages de données en colonnes traitent les informations par colonnes au lieu de lignes, ce qui accélère l’agrégation de requêtes, comme dans le cas des rapports.

Avantages

L’intérêt des entrepôts de données cloud pour toutes les entreprises modernes est évident grâce à leurs capacités d’analyse et d’information commerciale, qui améliorent les opérations et les services clients, conférant ainsi un avantage concurrentiel. Voici les avantages qu’offre l’utilisation d’un entrepôt de données cloud :

Fournisseurs d’entrepôts de données cloud

Maintenant que vous avez une idée du marché des entrepôts de données cloud, vous pouvez choisir celui qui convient le mieux à vos besoins. Bien que ceux présentés ici ne soient pas classés par ordre particulier, nous avons commencé par ceux qui ont la plus grande expertise technique.

Google BigQuery

Développé par Google, BigQuery est un entrepôt de données sans serveur entièrement géré, qui est automatiquement dimensionnable pour répondre à vos besoins en stockage et en calcul. À l’instar des autres produits Google, il offre de puissantes capacités d’analyse tout en restant rentable. Il est également fiable et propose divers outils d’informatique décisionnelle pour obtenir des informations et faire des prévisions précises. BigQuery est adapté aux agrégations complexes sur de vastes ensembles de données grâce à son stockage basé sur des colonnes.

Google vise à vous décharger de la gestion de votre infrastructure d’entrepôt. BigQuery masque donc le matériel sous-jacent, les nœuds, la base de données et les détails de configuration. Si vous souhaitez démarrer rapidement, il vous suffit de créer un compte avec Google Cloud Platform (GCP), de charger une table et d’exécuter une requête.

Vous pouvez également utiliser les bases de données en colonnes et SQL ANSI de BigQuery pour analyser des pétaoctets de données à une vitesse rapide. Ses capacités permettent de prendre en charge l’analyse spatiale via SQL et BigQuery GIS. De plus, vous pouvez créer et exécuter rapidement des modèles d’apprentissage automatique (ML) sur des données structurées, semi-structurées ou à grande échelle à l’aide de SQL simple et de BigQuery ML. Tirez également parti d’un tableau de bord interactif en temps réel grâce au moteur BigQuery BI.

Pour exploiter pleinement les fonctionnalités d’analyse de données de BigQuery, une bonne maîtrise de SQL est nécessaire, comme c’est le cas pour les autres entrepôts de données. Il est également rentable, mais le prix dépend de la qualité du code (vous payez pour la vitesse de traitement et le stockage). Il est donc important d’optimiser vos requêtes pour éviter les coûts élevés lors de l’extraction des données.

BigQuery gère les opérations informatiques lourdes en s’appuyant sur ses couches de calcul et de stockage séparées, ce qui le rend adapté aux organisations qui privilégient la disponibilité par rapport à la cohérence.

Redshift d’Amazon

Lancé en novembre 2021, Amazon Redshift est un entrepôt de données cloud entièrement géré capable de gérer des données à l’échelle du pétaoctet. Bien qu’il ne soit pas le premier entrepôt de données cloud, il est devenu le premier à se développer rapidement en part de marché après une adoption à grande échelle. Redshift utilise le dialecte SQL basé sur PostgreSQL, bien connu de nombreux analystes, et son architecture est similaire à celle des entrepôts de données sur site.

Cependant, Redshift se distingue des autres solutions de cette liste. Ses couches de calcul et de stockage ne sont pas totalement séparées. Cette architecture a un impact significatif sur les performances des requêtes analytiques si vous effectuez de nombreuses opérations d’écriture. Par conséquent, vous aurez besoin de personnel interne pour maintenir les systèmes à jour avec des opérations de maintenance et des mises à jour régulières.

Si vous recherchez une excellente cohérence au niveau des lignes, comme dans le secteur bancaire, Redshift est un choix judicieux. Cependant, ce n’est peut-être pas le meilleur choix si votre organisation doit effectuer simultanément des opérations d’écriture et de traitement.

Snowflake

L’entrepôt de données cloud Snowflake est unique en son genre : il est entièrement géré et fonctionne sur AWS, GCP et Azure, contrairement aux autres entrepôts décrits ici qui fonctionnent sur leur propre cloud. Snowflake est facile à utiliser et est connu pour sa capacité avancée à transformer, exécuter des requêtes rapides, bénéficier d’une sécurité élevée et évoluer automatiquement selon vos besoins.

La base de code flexible de Snowflake vous permet d’exécuter des activités de réplication de données mondiales, telles que le stockage de données dans n’importe quel cloud, sans avoir à recoder ni à acquérir de nouvelles compétences.

Snowflake convient aux analystes de données de tous niveaux car il n’utilise pas les langages de programmation Python ou R. Il est également réputé pour son stockage sécurisé et compressé de données semi-structurées. En outre, il vous permet d’utiliser plusieurs entrepôts virtuels en fonction de vos besoins tout en parallélisant et en isolant les requêtes individuelles, ce qui améliore leurs performances. Vous pouvez interagir avec Snowflake via un navigateur Web, la ligne de commande, des plateformes d’analyse et d’autres pilotes pris en charge.

Bien que Snowflake soit apprécié pour sa capacité à exécuter des requêtes qui ne sont pas possibles avec d’autres solutions, la création de tableaux de bord optimisés nécessite un codage de fonctions et de routines personnalisées.

Snowflake est populaire parmi les entreprises de taille moyenne qui n’ont pas besoin d’effectuer des opérations d’écriture et de traitement à grand volume ou qui nécessitent une cohérence sur de grands volumes de données.

Base de données SQL Azure

Ce produit est une base de données gérée en tant que service, disponible dans le cadre de Microsoft Azure, la plateforme de cloud computing. Si votre entreprise utilise déjà les outils commerciaux de Microsoft, il pourrait s’agir d’un choix naturel pour vous.

La base de données Azure SQL est largement utilisée pour l’hébergement basé sur le cloud, avec un parcours utilisateur interactif, de la création de serveurs SQL à la configuration des bases de données. Elle est également très appréciée pour son interface facile à utiliser et ses nombreuses fonctionnalités de manipulation des données. En outre, elle est évolutive pour réduire les coûts et optimiser les performances en cas de faible utilisation.

Cependant, elle n’est pas conçue pour de grandes charges de données. Elle est adaptée aux charges de travail de traitement des transactions en ligne (OLTP) et gère de gros volumes de processus de lecture et d’écriture.

Cet outil serait un choix judicieux si votre entreprise traite des requêtes simples et de petites charges de données. Toutefois, ce n’est pas le meilleur choix si votre entreprise a besoin d’une puissance de calcul analytique importante.

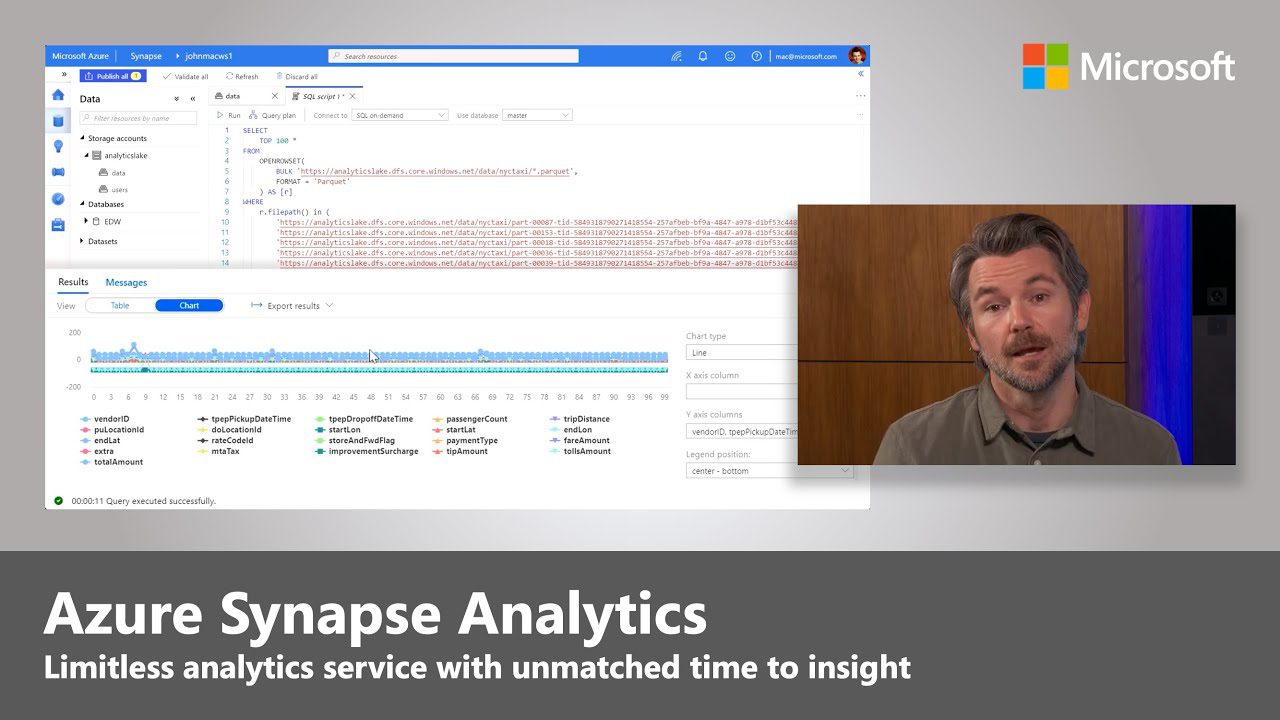

Azure Synapse

Cette section de la plateforme Azure est orientée vers l’analyse et combine plusieurs services tels que l’intégration de données, l’entreposage de données et l’analyse de données volumineuses. Bien qu’elle puisse sembler similaire à la base de données Azure SQL, elle est différente.

Azure Synapse Analytics est évolutif pour les grandes tables de données grâce à son informatique distribuée. Il s’appuie sur le MPP (mentionné précédemment, n’hésitez pas à revenir si vous n’avez pas bien compris) pour exécuter rapidement des requêtes complexes sur plusieurs nœuds. L’accent est mis sur la sécurité et la confidentialité avec Synapse.

Bien qu’il s’agisse d’une option standard pour les entreprises qui utilisent déjà les outils Microsoft, il est difficile de l’intégrer avec des produits autres que les entrepôts de données d’autres sociétés. Le service peut parfois présenter des bogues, car il est constamment mis à jour.

Azure Synapse est conçu pour le traitement analytique en ligne et est donc préférable pour le traitement de grands ensembles de données en temps réel. Vous pouvez envisager d’utiliser Azure Synapse au lieu de SQL si les données de votre entrepôt dépassent un téraoctet.

Firebolt

Bien qu’il soit encore relativement nouveau, Firebolt prétend être un entrepôt de nouvelle génération, fonctionnant 182 fois plus vite que les systèmes basés sur SQL. Firebolt est rapide car il utilise de nouvelles techniques d’analyse et de compression des données.

Lors de ses requêtes, il accède à de petites plages de données à l’aide d’index, contrairement à d’autres entrepôts de données qui utilisent des partitions et des segments entiers, libérant ainsi la bande passante de votre réseau. Il est évolutif et peut interroger de vastes ensembles de données à des vitesses impressionnantes.

Bien qu’il soit nouveau sur le marché, il ne s’intègre pas à l’ensemble de l’écosystème (qui est vaste) des plateformes d’entreprise et des outils d’intelligence. Cependant, ce problème peut être facilement résolu à l’aide d’un outil spécifique d’extraction, de transformation et de chargement (ETL) pour acheminer les données vers et depuis l’entrepôt.

Les puissances de stockage et de calcul de Firebolt sont séparées, ce qui le rend économique pour les petites et grandes institutions. Il est particulièrement adapté aux entreprises qui ont besoin d’analyses rapides, mais il est nécessaire de disposer d’analystes de données internes expérimentés.

Choisir le bon entrepôt de données cloud

Pour choisir un entrepôt de données cloud adapté à vos besoins, il est important de prendre en compte la taille de votre entreprise et la façon dont vous gérez les données. Si vous dirigez une petite entreprise qui gère de petites quantités de données et qui dispose de peu ou pas de ressources humaines pour gérer le secteur de l’analyse des données, comme certains sites de commerce électronique, vous opterez probablement pour un entrepôt facile à utiliser et rentable en termes de performances.

En revanche, si vous dirigez une grande entreprise qui a besoin d’un ensemble de données spécifique, vous devrez faire face à des compromis. Ce compromis est décrit dans le théorème CAP, qui stipule que toute donnée distribuée garantit la sécurité, la disponibilité et la tolérance de partition (c’est-à-dire la protection contre les pannes). Dans la plupart des cas, chaque entreprise aura besoin d’une tolérance partielle, ce qui laisse un compromis entre cohérence et disponibilité.

Vous pouvez maintenant consulter les outils d’intégration de données les plus fiables.