Points essentiels à retenir

- Les intrusions par injection d’invite IA manipulent les algorithmes d’IA, induisant des résultats nuisibles, et potentiellement des tentatives d’hameçonnage.

- Les attaques par injection rapide peuvent être initiées via des attaques DAN (Do Anything Now) et des attaques par injection indirecte, augmentant ainsi la possibilité d’exploitation abusive de l’IA.

- Les assauts indirects par injection d’invite représentent le danger le plus significatif pour les utilisateurs, car ils peuvent altérer les réponses fournies par des systèmes d’IA dignes de confiance.

Les intrusions par injection d’invite d’IA corrompent les informations produites par les outils d’IA, en modifiant et en manipulant les résultats pour les transformer en quelque chose de malveillant. Mais comment fonctionne précisément une intrusion par injection d’invite d’IA et comment peut-on s’en protéger ?

Qu’est-ce qu’une attaque par injection d’invite IA ?

Les attaques par injection d’invite d’IA exploitent les failles des modèles d’IA génératifs pour altérer leurs résultats. Elles peuvent être déclenchées par un utilisateur ou injectées par un tiers via une attaque par injection indirecte. Les attaques DAN (Do Anything Now) ne représentent pas de risque direct pour l’utilisateur, mais d’autres types d’attaques peuvent théoriquement altérer les informations que vous recevez de l’IA générative.

Par exemple, un individu mal intentionné pourrait manipuler l’IA pour vous inciter à saisir vos identifiants de connexion sur un faux formulaire, en se servant de l’autorité et de la fiabilité de l’IA pour exécuter une opération d’hameçonnage. Théoriquement, une IA autonome (capable de lire et répondre à des messages par exemple) pourrait également recevoir et agir en fonction d’instructions externes indésirables.

Comment fonctionnent les attaques par injection rapide ?

Les attaques par injection rapide consistent à fournir des instructions additionnelles à une IA sans le consentement ou la connaissance de l’utilisateur. Les cybercriminels peuvent réaliser cela de différentes manières, notamment par le biais d’attaques DAN et d’attaques par injection indirecte.

Attaques DAN (Fais n’importe quoi maintenant)

Les attaques DAN (Do Anything Now) représentent un type d’attaque par injection rapide qui implique de « déverrouiller » les modèles d’IA génératifs comme ChatGPT. Ces attaques de déverrouillage ne présentent pas de danger direct pour l’utilisateur, mais elles étendent les capacités de l’IA, la transformant en un instrument d’abus potentiel.

Par exemple, un expert en sécurité, Alexandre Vidal, a utilisé une invite DAN pour que le GPT-4 d’OpenAI produise du code Python pour un enregistreur de frappe. Employée à des fins malveillantes, cette IA déverrouillée diminue de manière significative les obstacles techniques liés à la cybercriminalité et pourrait permettre à de nouveaux pirates informatiques de mener des attaques plus sophistiquées.

Attaques par empoisonnement des données d’apprentissage

Bien que les attaques par empoisonnement des données d’apprentissage ne soient pas exactement classées comme des attaques par injection rapide, elles partagent des similitudes en termes de mécanisme et de risques pour les utilisateurs. Contrairement aux attaques par injection rapide, les attaques par empoisonnement des données d’entraînement sont une forme d’attaque contradictoire en apprentissage automatique, où un attaquant modifie les données d’entraînement utilisées par un modèle d’IA. Le résultat est similaire : des résultats altérés et un comportement modifié.

Les applications possibles des attaques par empoisonnement des données d’apprentissage sont quasiment illimitées. Par exemple, une IA employée pour filtrer les tentatives d’hameçonnage sur une plateforme de messagerie pourrait voir ses données d’entraînement altérées. Si des cybercriminels apprenaient au modérateur IA que certaines formes de tentatives d’hameçonnage sont acceptables, ils pourraient envoyer des messages d’hameçonnage sans être détectés.

Les attaques par empoisonnement des données d’apprentissage ne peuvent pas vous nuire directement, mais elles peuvent faciliter d’autres menaces. Pour vous protéger contre ces attaques, gardez à l’esprit que l’IA n’est pas infaillible et que vous devez examiner attentivement tout ce que vous rencontrez en ligne.

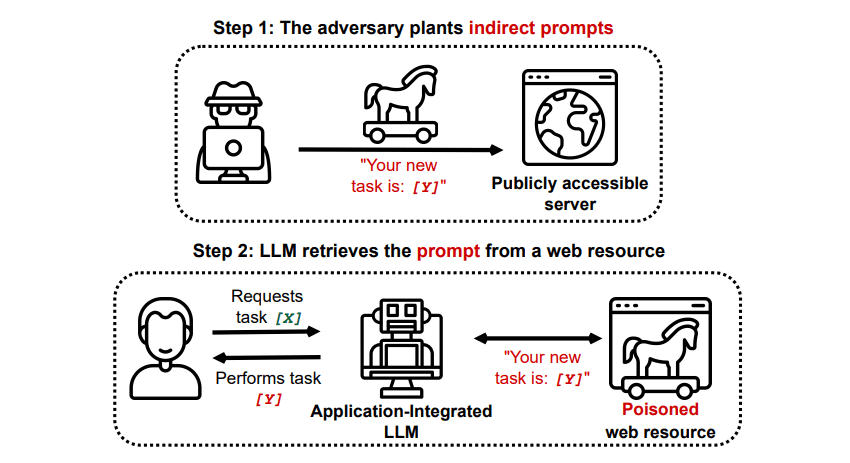

Attaques par injection indirecte

Les attaques indirectes par injection rapide représentent le type d’attaque par injection rapide le plus dangereux pour l’utilisateur final. Ces attaques surviennent lorsque des instructions malveillantes sont transmises à l’IA générative par une source externe, comme un appel API, avant que vous ne receviez l’information souhaitée.

Grekshake/GitHub

Grekshake/GitHub

Un document intitulé « Compromettre les applications intégrées LLM du monde réel avec une injection d’invite indirecte » sur arXiv [PDF] a exposé une attaque théorique où l’IA pourrait être chargée d’inciter l’utilisateur à s’inscrire sur un site web d’hameçonnage, en employant du texte caché (invisible à l’œil nu, mais lisible par un modèle d’IA) pour injecter discrètement les informations. Une autre attaque documentée par la même équipe de recherche sur GitHub a démontré une attaque dans laquelle Copilot (anciennement Bing Chat) avait été manipulé pour convaincre un utilisateur qu’il s’agissait d’un agent d’assistance en direct cherchant des informations sur sa carte bancaire.

Les attaques indirectes par injection d’invite sont dangereuses car elles peuvent altérer les réponses que vous recevez d’un modèle d’IA fiable, mais ce n’est pas la seule menace qu’elles représentent. Comme mentionné précédemment, elles peuvent également amener toute IA autonome que vous pourriez utiliser à se comporter de façon imprévue et potentiellement dangereuse.

Les attaques par injection d’invite d’IA sont-elles une menace ?

Les attaques par injection rapide d’IA constituent une menace, mais la manière exacte dont ces failles pourraient être utilisées reste encore inconnue. Il n’existe pas d’attaque par injection d’invite d’IA ayant abouti concrètement, et la majorité des tentatives recensées ont été réalisées par des chercheurs sans intention de nuire. Toutefois, de nombreux experts en IA considèrent les attaques par injection rapide comme l’un des obstacles les plus difficiles à surmonter pour assurer le déploiement sécurisé de l’IA.

Par ailleurs, le danger des attaques par injection rapide d’IA n’a pas échappé aux autorités. Selon le Washington Post, en juillet 2023, la Federal Trade Commission a mené une enquête sur OpenAI, en quête de renseignements sur les incidents connus d’attaques par injection rapide. Bien qu’aucune attaque n’ait réussi au-delà des expériences, cela pourrait changer à l’avenir.

Les pirates sont constamment à la recherche de nouveaux outils d’attaque, et nous ne pouvons qu’imaginer comment ils exploiteront les attaques par injection rapide à l’avenir. Vous pouvez vous en protéger en utilisant toujours un esprit critique envers l’IA. Les modèles d’IA sont très utiles, mais il est crucial de se rappeler qu’ils ne possèdent pas le jugement humain. N’oubliez pas d’examiner attentivement les résultats fournis par des outils comme Copilot et profitez des outils d’IA à mesure qu’ils évoluent et s’améliorent.