L’analyse des fichiers journaux SEO aide à comprendre le comportement du crawler sur le site Web et à identifier les opportunités techniques potentielles d’optimisation SEO.

Le référencement sans analyser le comportement des crawlers revient à voler à l’aveugle. Vous avez peut-être soumis le site Web sur la console de recherche Google et l’avez indexé, mais sans étudier les fichiers journaux, vous ne saurez pas si votre site Web est correctement exploré ou lu par les robots des moteurs de recherche.

C’est pourquoi j’ai rassemblé tout ce que vous devez savoir pour analyser les fichiers journaux de référencement et identifier les problèmes et les opportunités de référencement à partir de ceux-ci.

Table des matières

Qu’est-ce que l’analyse des fichiers journaux ?

L’analyse des fichiers journaux SEO est un processus permettant de reconnaître le modèle d’interaction des robots des moteurs de recherche avec le site Web. L’analyse des fichiers journaux fait partie du référencement technique.

L’audit des fichiers journaux est important pour que les référenceurs reconnaissent et résolvent les problèmes liés à l’exploration, à l’indexation et aux codes d’état.

Que sont les fichiers journaux ?

Les fichiers journaux suivent les visiteurs d’un site Web et le contenu qu’ils consultent. Ils contiennent des informations sur la personne qui a demandé l’accès au site Web (également appelé « le client »).

Les informations perçues peuvent être liées à des robots de moteurs de recherche comme Google ou Bing ou à un visiteur de site Web. En règle générale, les enregistrements des fichiers journaux sont collectés et conservés par le serveur Web du site, et ils sont généralement conservés pendant un certain temps.

Que contient le fichier journal ?

Avant de connaître l’importance des fichiers journaux pour le référencement, il est essentiel de savoir ce qu’il y a à l’intérieur de ce fichier. Le fichier journal e contient les points de données suivants : –

- URL de la page demandée par le visiteur du site Web

- Le code d’état HTTP de la page

- Adresse IP du serveur demandé

- Date et heure du coup

- Données de l’agent utilisateur (bot du moteur de recherche) faisant une demande

- Méthode de requête (GET/POST)

Les fichiers journaux peuvent vous sembler compliqués si vous les regardez en premier. Néanmoins, une fois que vous connaîtrez le but et l’importance des fichiers journaux pour le référencement, vous les utiliserez efficacement pour générer de précieuses informations sur le référencement.

Objectif de l’analyse des fichiers journaux pour le référencement

L’analyse du fichier journal aide à résoudre certains des problèmes techniques de référencement importants, ce qui vous permet de créer une stratégie de référencement efficace pour optimiser le site Web.

Voici quelques problèmes de référencement qui peuvent être analysés à l’aide de fichiers journaux :

#1. Fréquence à laquelle Googlebot explore le site Web

Les robots ou les robots des moteurs de recherche doivent explorer fréquemment vos pages importantes afin que le moteur de recherche soit informé des mises à jour de votre site Web ou du nouveau contenu.

Vos pages de produits ou d’informations importantes doivent toutes apparaître dans les journaux de Google. Une page produit pour un produit que vous ne vendez plus, ainsi que l’absence de l’une de vos pages de catégorie les plus importantes, sont des indicateurs d’un problème qui peut être reconnu à l’aide de fichiers journaux.

Comment un robot de moteur de recherche utilise-t-il le budget de crawl ?

Chaque fois qu’un robot d’exploration des moteurs de recherche visite votre site, il dispose d’un « budget d’exploration » limité. Google définit un budget de crawl comme la somme du taux de crawl d’un site et de la demande de crawls.

L’exploration et l’indexation d’un site peuvent être entravées s’il contient de nombreuses URL de faible valeur ou des URL qui ne sont pas correctement soumises dans le sitemap. Le crawl et l’indexation des pages clés sont plus faciles si votre budget de crawl est optimisé.

L’analyse des fichiers journaux permet d’optimiser le budget de crawl qui accélère les efforts de référencement.

#2. Problèmes et état de l’indexation mobile-first

L’indexation mobile d’abord est désormais importante pour tous les sites Web, et Google la préfère. L’analyse du fichier journal vous indiquera la fréquence à laquelle Googlebot par smartphone parcourt votre site.

Cette analyse aide les webmasters à optimiser les pages Web pour les versions mobiles si les pages ne sont pas correctement explorées par Googlebot pour smartphone.

#3. Code d’état HTTP renvoyé par les pages Web lorsqu’il est demandé

Les codes de réponse récents que nos pages Web renvoient peuvent être récupérés soit par des fichiers journaux, soit à l’aide de l’option de demande d’extraction et de rendu dans Google Search Console.

Les analyseurs de fichiers journaux peuvent trouver les pages avec les codes 3xx, 4xx et 5xx. Vous pouvez résoudre ces problèmes en prenant les mesures appropriées, par exemple en redirigeant les URL vers les bonnes destinations ou en modifiant l’état 302 codé en 301.

#4. Analyser les activités de crawl comme la profondeur de crawl ou les liens internes

Google apprécie la structure de votre site en fonction de sa profondeur d’exploration et de ses liens internes. Les raisons d’une mauvaise exploration du site Web peuvent être une mauvaise structure de liens et une mauvaise profondeur d’exploration.

Si vous rencontrez des difficultés avec la hiérarchie ou la structure du site de votre site Web, ou la structure des liens, vous pouvez utiliser l’analyse des fichiers journaux pour les trouver.

L’analyse du fichier journal permet d’optimiser l’architecture du site Web et la structure des liens.

#4. Découvrez les pages orphelines

Les pages orphelines sont les pages Web du site Web qui ne sont liées à aucune autre page. Il est difficile pour ces pages d’être indexées ou d’apparaître dans les moteurs de recherche car elles ne sont pas facilement découvertes par les bots.

Les pages orphelines peuvent être facilement découvertes par des robots tels que Screaming Frog, et ce problème peut être résolu en reliant ces pages aux autres pages du site Web.

#5. Auditez les pages pour la vitesse et l’expérience de la page

L’expérience de la page et les éléments vitaux Web de base sont désormais officiellement les facteurs de classement, et il est important maintenant que les pages Web soient conformes aux directives de vitesse de page de Google.

Les pages lentes ou volumineuses peuvent être découvertes à l’aide d’analyseurs de fichiers journaux, et ces pages peuvent être optimisées pour la vitesse des pages, ce qui aidera au classement général sur le SERP.

L’analyse des fichiers journaux vous aide à contrôler la façon dont votre site Web est exploré et la façon dont les moteurs de recherche gèrent votre site Web

Maintenant que nous avons compris les bases des fichiers journaux et leur analyse, examinons le processus d’audit des fichiers journaux pour le référencement.

Comment faire une analyse de fichier journal

Nous avons déjà examiné différents aspects des fichiers journaux et l’importance du référencement. Il est maintenant temps d’apprendre le processus d’analyse des fichiers et les meilleurs outils pour analyser les fichiers journaux.

Vous aurez besoin d’accéder au fichier journal du serveur du site Web pour accéder au fichier journal. Les fichiers peuvent être analysés des manières suivantes :

L’accès manuel aux fichiers journaux comporte différentes étapes.

- Collectez ou exportez les données du journal à partir du serveur Web, et les données doivent être filtrées pour les robots ou les robots des moteurs de recherche.

- Convertissez le fichier téléchargé dans un format lisible à l’aide d’outils d’analyse de données.

- Analysez manuellement les données à l’aide d’Excel ou d’autres outils de visualisation pour trouver les lacunes et les opportunités de référencement.

- Vous pouvez également utiliser des programmes de filtrage et des lignes de commande pour vous faciliter la tâche

Travailler manuellement sur les données des fichiers n’est pas facile car cela nécessite une connaissance d’Excel et implique l’équipe de développement. Pourtant, les outils d’analyse des fichiers journaux facilitent la tâche des référenceurs.

Examinons les meilleurs outils d’audit des fichiers journaux et comprenons comment ces outils nous aident à analyser les fichiers journaux.

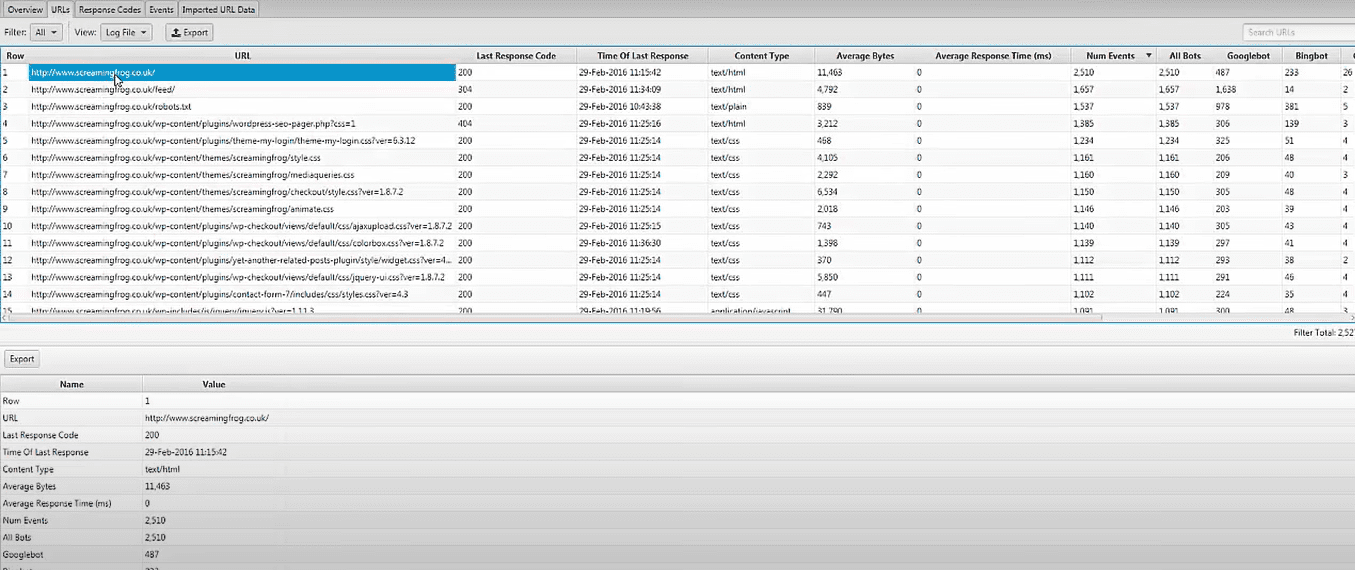

Analyseur de fichiers journaux Screaming Frog

Les problèmes techniques de référencement peuvent être identifiés à l’aide des données de fichier journal téléchargées et les robots des moteurs de recherche vérifiés à l’aide du Analyseur de fichiers journaux Screaming Frog. Vous pouvez également procéder comme suit :

- Activité et données des robots des moteurs de recherche pour l’optimisation des moteurs de recherche.

- Découvrez la fréquence de crawl du site Web par les robots des moteurs de recherche

- Découvrez tous les problèmes techniques de référencement et les liens brisés externes et internes

- Analyse des URL les moins et les plus crawlées pour réduire les pertes et gagner en efficacité.

- Découvrez les pages qui ne sont pas explorées par les moteurs de recherche.

- Toutes les données peuvent être comparées et combinées, y compris les données de liens externes, les directives et d’autres informations.

- Afficher les données sur les URL de référence

L’outil d’analyse de fichiers journaux Screaming Frog est entièrement gratuit pour un seul projet avec une limite de 1000 événements de journal de ligne. Vous devrez passer à la version payante si vous souhaitez un accès illimité et une assistance technique.

JetOctopus

En ce qui concerne les outils d’analyse de journaux abordables, JetOctopus est le meilleur. Il propose un essai gratuit de sept jours, aucune carte de crédit requise et une connexion en deux clics. La fréquence de crawl, le budget de crawl, les pages les plus populaires, etc. peuvent tous être identifiés à l’aide de Analyseur de journaux JetOctopustout comme les autres outils de notre liste.

Avec cet outil, vous pouvez intégrer les données du fichier journal aux données de la Google Search Console, ce qui vous donne un net avantage sur la concurrence. Avec ce combo, vous pourrez voir comment Googlebot interagit avec votre site et où vous pouvez vous améliorer.

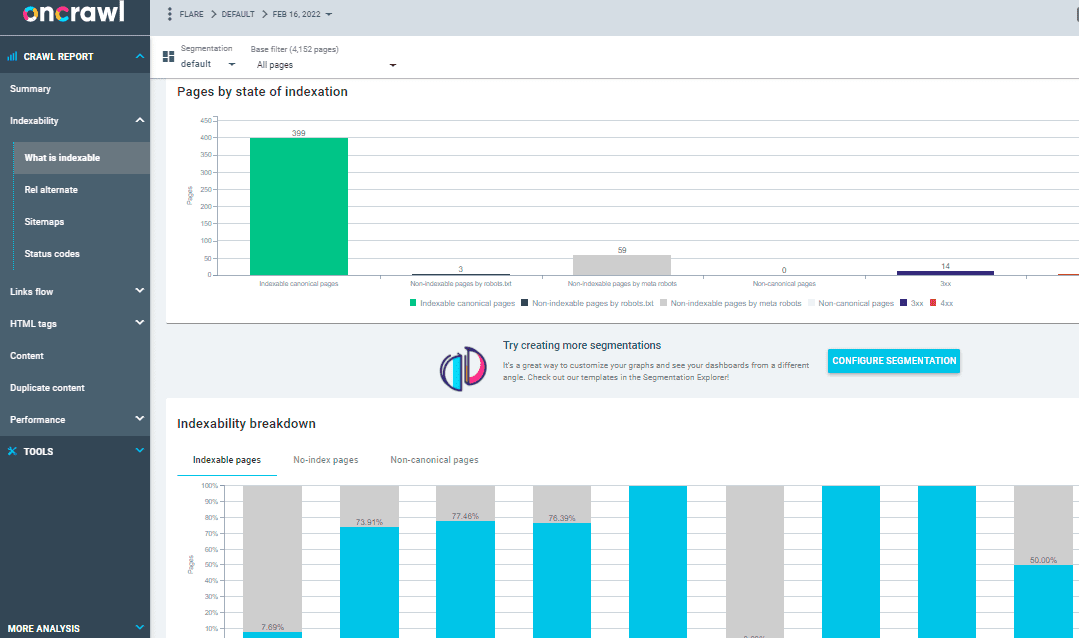

Sur l’analyseur de journaux d’exploration

Plus de 500 millions de lignes de log par jour sont traitées par Analyseur de journaux Oncrawl, un outil conçu pour les sites Web de taille moyenne à grande. Il garde un œil sur les journaux de votre serveur Web en temps réel pour s’assurer que vos pages sont correctement indexées et explorées.

Oncrawl Log Analyzer est conforme au RGPD et hautement sécurisé. Au lieu d’adresses IP, le programme stocke tous les fichiers journaux dans un nuage FTP sécurisé et séparé.

Outre JetOctopus et Screaming Frog Log File Analyzer, Oncrawl a quelques fonctionnalités supplémentaires, telles que :

- Prend en charge de nombreux formats de journaux, tels que IIS, Apache et Nginx.

- L’outil s’adapte facilement à vos besoins de traitement et de stockage à mesure qu’ils changent

- La segmentation dynamique est un outil puissant pour découvrir des modèles et des connexions dans vos données en regroupant vos URL et liens internes en fonction de divers critères.

- Utilisez les points de données de vos fichiers journaux bruts pour créer des rapports SEO exploitables.

- Les fichiers journaux transférés sur votre espace FTP peuvent être automatisés avec l’aide du personnel technique.

- Tous les navigateurs populaires peuvent être surveillés, y compris Google, Bing, Yandex et les robots d’exploration de Baidu.

OnCrawl Log Analyzer dispose de deux autres outils importants :

Robot d’exploration SEO Oncrawl : Avec Oncrawl SEO Crawler, vous pouvez explorer votre site Web à grande vitesse et avec un minimum de ressources. Améliore la compréhension de l’utilisateur de la façon dont les critères de classement affectent l’optimisation des moteurs de recherche (SEO).

Données d’exploration : Les données Oncrawl analysent tous les facteurs SEO en combinant les données du crawl et des analyses. Il récupère les données du crawl et des fichiers journaux pour comprendre le comportement du crawl et recommande le budget de crawl au contenu prioritaire ou aux pages de classement.

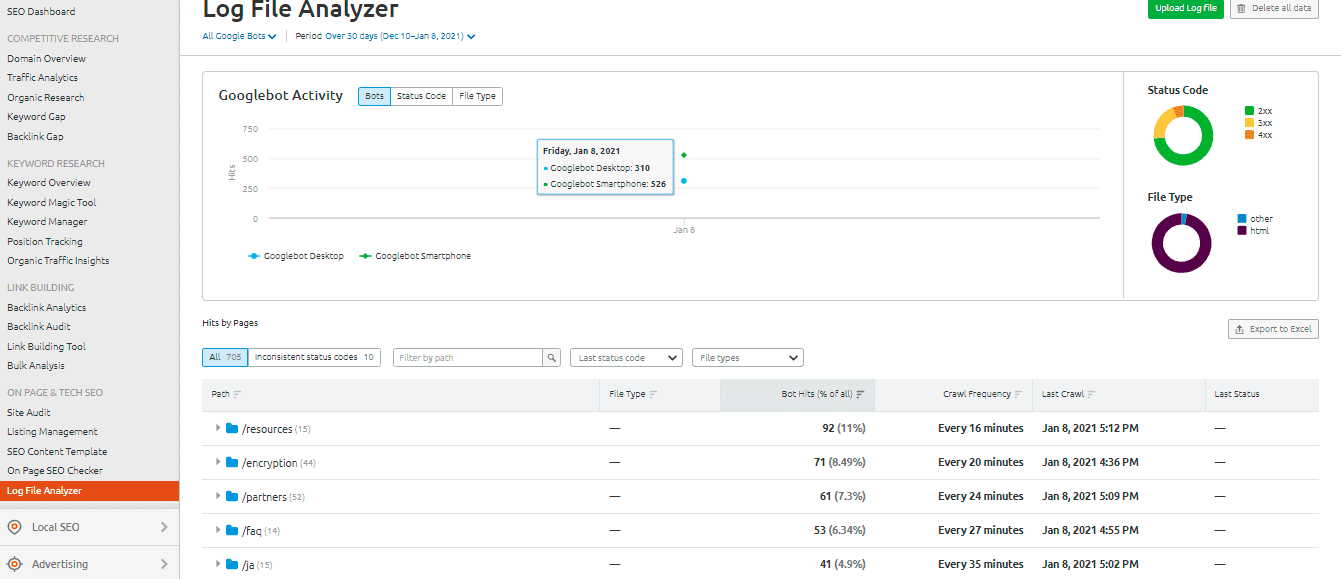

Analyseur de fichiers journaux SEMrush

La Analyseur de fichiers journaux SEMrush est un choix judicieux pour un outil d’analyse de journaux simple et basé sur un navigateur. Cet analyseur ne nécessite pas de téléchargement et peut être utilisé dans la version en ligne.

SEMrush vous présente deux rapports :

Accès aux pages: Pages’ Hits rapporte l’interaction des robots d’indexation avec le contenu de votre site Web. Il vous donne les données des pages, des dossiers et des URL avec les interactions maximales et minimales avec les bots.

L’activité du Googlebot: Le rapport d’activité de Googlebot fournit quotidiennement des informations sur le site, telles que :

- Les types de fichiers explorés

- Le code d’état HTTP global

- Le nombre de requêtes effectuées sur votre site par différents bots

Connectez-vous depuis SolarWinds

Loggly de SolarWinds examine les journaux d’accès et d’erreurs de votre serveur Web, ainsi que les statistiques hebdomadaires du site. Vous pouvez voir vos données de journal à tout moment et ses fonctionnalités facilitent la recherche dans les journaux.

Un outil d’analyse de fichiers journaux robuste comme SolarWinds Loggly est nécessaire pour extraire efficacement les fichiers journaux de votre serveur Web afin d’obtenir des informations sur le succès ou l’échec des demandes de ressources des clients.

Loggly peut fournir des graphiques affichant les pages les moins consultées et calculer les vitesses de chargement de page moyennes, minimales et maximales pour vous aider à optimiser l’optimisation des moteurs de recherche de votre site Web.

Statistiques d’exploration de la console de recherche Google

Console de recherche Google a facilité la tâche des utilisateurs en fournissant un aperçu utile de ses pratiques. Le fonctionnement de la console est simple. Vos statistiques de crawl seront alors divisées en trois catégories :

- Kilooctets téléchargés par jour : Il indique les kilooctets téléchargés par Googlebots lors de la visite du site Web. Cela indique essentiellement deux points importants : si des moyennes élevées sont affichées dans le graphique, cela signifie que le site est exploré plus souvent ou cela peut également indiquer que le bot prend beaucoup de temps pour explorer un site Web et qu’il n’est pas léger.

- Pages explorées par jour : il vous indique le nombre de pages que Googlebot explore chaque jour. Il note également l’état de l’activité d’exploration, qu’il soit faible, élevé ou moyen. Un faible taux d’exploration indique que le site Web n’est pas exploré correctement par Googlebot

- Temps passé à télécharger une page (en millisecondes) : cela indique le temps mis par Googlebot pour effectuer des requêtes HTTP lors de l’exploration du site Web. Moins de temps Googlebot doit passer à faire des requêtes, le téléchargement de la page sera meilleur car l’indexation sera plus rapide.

Conclusion

J’espère que vous avez beaucoup appris de ce guide sur l’analyse des fichiers journaux et les outils utilisés pour auditer les fichiers journaux pour le référencement. L’audit des fichiers journaux peut être très efficace pour améliorer les aspects techniques du référencement du site Web.

Google Search Console et SEMrush Log File Analyzer sont deux options pour un outil d’analyse gratuit et basique. Comme alternative, consultez Screaming Frog Log File Analyzer, JetOctopus ou Oncrawl Log Analyzer pour mieux comprendre comment les robots des moteurs de recherche interagissent avec votre site Web ; vous pouvez utiliser des outils d’analyse de fichiers journaux premium et gratuits pour le référencement.

Vous pouvez également consulter certains robots d’exploration de sites Web avancés pour améliorer le référencement.