Optimisation des Performances Applicatives : Comparaison Approfondie de Redis et Memcached

Les solutions de mise en cache représentent un pilier essentiel pour l’amélioration de la réactivité des applications. Dans la quête des meilleures options, Redis et Memcached se distinguent comme deux des choix les plus prisés par les développeurs.

Face à ces deux alternatives populaires, comment choisir la plus adaptée à vos besoins ? Ce guide comparatif vous fournira les informations nécessaires pour comprendre les atouts de chacun et vous orienter vers une décision éclairée.

Que votre objectif soit d’accélérer le fonctionnement de vos applications, d’alléger la charge de votre base de données ou de permettre une montée en charge fluide de votre système, une bonne compréhension des solutions de mise en cache est primordiale.

Bien que Redis et Memcached puissent tous deux servir de solutions de mise en cache d’applications, ils offrent des fonctionnalités propres. Ils excellent tous deux par leurs latences inférieures à la milliseconde et leurs débits élevés, mais ils se différencient notamment par la gestion des structures de données et le stockage.

Avant de nous plonger dans une comparaison détaillée entre Redis et Memcached, examinons d’abord les principes de la mise en cache.

Qu’est-ce que la Mise en Cache et Pourquoi Est-elle Indispensable ?

Chaque action effectuée par une application sollicite les ressources de votre système. Cela peut prendre la forme d’une activité gourmande en CPU ou encore d’une opération impliquant le réseau, telle que la lecture de fichiers ou l’interrogation d’une base de données.

Les performances de votre système peuvent être fortement impactées si vous exécutez de manière répétée la même tâche gourmande en ressources (CPU ou réseau). Imaginez que vous ayez besoin de consulter une base de données via une requête complexe. Le calcul et l’extraction des données prendront non seulement du temps, mais la requête elle-même consommera des ressources supplémentaires de la base de données.

Considérez maintenant le cas où le résultat de la requête demeure identique entre deux consultations successives. Vous exécutez pourtant la même requête coûteuse à chaque fois. S’il existait une alternative ? C’est là que la mise en cache entre en jeu.

Essentiellement, la mise en cache consiste à stocker des données fréquemment consultées dans une mémoire rapide. Cela permet une récupération rapide lorsque ces mêmes données sont requises à nouveau. En outre, elle permet d’éviter la répétition d’opérations gourmandes en ressources telles que les requêtes de base de données ou les calculs complexes. En somme, la mise en cache améliore l’efficacité et la réactivité de votre système.

Voici les principaux bénéfices apportés par la mise en cache :

- Diminution des latences

- Chargement et réponse plus rapides des sites Web et applications

- Réduction de l’utilisation inutile des ressources

- Moins de pression sur les serveurs dorsaux

- Protection de la base de données contre les requêtes lourdes fréquentes

Redis : Vue d’Ensemble

Redis est un entrepôt de données open source fonctionnant en mémoire. Les données y sont stockées sous la forme de paires clé-valeur. Au-delà de son usage comme solution de mise en cache, Redis peut servir de base de données, de courtier de messages ou de file d’attente.

De par son exécution en mémoire vive, Redis offre des latences de requête inférieures à la milliseconde. La récupération des données depuis la mémoire est considérablement plus rapide que depuis un disque dur. Par conséquent, il affiche un débit très élevé et prend en charge un grand nombre de lectures et d’écritures par seconde.

Dans le cadre d’une comparaison entre Redis et Memcached, Redis se démarque par sa prise en charge d’un large éventail de structures de données. Vous avez la possibilité de stocker tout type de texte ou de données binaires sous forme de chaînes de caractères (taille maximale de 512 Mo). Pour le stockage d’objets, vous pouvez recourir à des paires champ-valeur, appelées hachages. Si vous avez besoin de conserver une collection de chaînes, vous pouvez utiliser des listes, des ensembles ou des ensembles triés.

Redis assure une compatibilité avec les bibliothèques client des principaux langages de programmation, comme Java, Python, Go, NodeJs, C# et .Net. Par ailleurs, son installation fournit un utilitaire en ligne de commande nommé `redis-cli`. Cet outil permet de vérifier rapidement le fonctionnement du serveur et d’envoyer des commandes pour la lecture, l’écriture ou la modification des données.

Avantages de Redis

- Open source et gratuit

- Clients officiels disponibles pour les principaux langages de programmation

- Utilisable comme solution de mise en cache, courtier de messages, base de données ou file d’attente

- Offre de très hautes performances avec des latences inférieures à la milliseconde

- Intégration de plusieurs structures de données : chaînes, listes, ensembles et ensembles triés

- Haute disponibilité et évolutivité grâce à une architecture de réplication maître-esclave

Nous allons maintenant examiner Memcached en détail.

Memcached : Vue d’Ensemble

Memcached est un système de mise en cache d’objets en mémoire distribuée, à la fois gratuit et open source. Il garantit des performances élevées. Vous bénéficiez d’un stockage clé-valeur en mémoire pour des données de petite taille. Cependant, avant de comparer Redis et Memcached, voyons plus précisément le fonctionnement de Memcached.

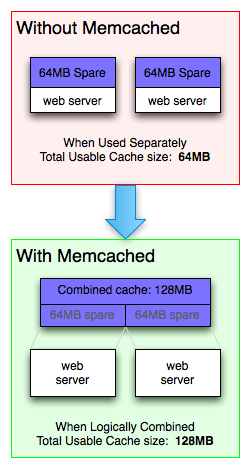

La mémoire d’un système informatique n’est pas utilisée de manière uniforme. La mémoire libre est constituée de blocs arbitraires de différentes tailles. Memcached permet d’accéder à la mémoire disponible à partir de différentes parties du système. La mémoire est ainsi utilisée à bon escient.

En tant que simple stockage clé-valeur, les serveurs Memcached ne traitent pas le sens des données. Vous stockez des données brutes pré-sérialisées accompagnées d’une clé, d’une heure d’expiration et d’indicateurs optionnels. Il n’y a pas de prise en charge de structures de données intégrées.

Contrairement à Redis, les serveurs Memcached ne communiquent pas entre eux. Il n’y a ni synchronisation, ni réplication, ni diffusion. La disponibilité et l’invalidation du cache sont donc simplifiées. En tant que client, vous supprimez ou écrasez les données directement sur le serveur qui les possède.

Grâce à cette architecture très simple, Memcached offre de très hautes performances. Sur une machine rapide dotée d’un réseau haut débit, Memcached peut facilement gérer plus de 200 000 requêtes par seconde.

Avantages de Memcached

- Récupération plus rapide grâce aux données stockées en mémoire vive (par rapport aux disques traditionnels)

- API disponibles pour les langages de programmation les plus répandus

- Réduit le besoin de recherches de données répétitives grâce à la mise en cache des résultats

- Peut mettre en cache des résultats de base de données, des réponses d’API, ou même des pages Web

- Permet de récupérer la mémoire fragmentée

- Utilise la technique de mise en cache LRU (Least Recently Used), et les éléments expirent après une durée spécifique

- Permet de créer ses propres abstractions

Nous allons maintenant explorer les différences entre Redis et Memcached.

Redis vs Memcached : Tableau Comparatif

| Caractéristiques | Redis | Memcached |

| Structures de données | Prise en charge de structures de données intégrées : chaînes, listes, ensembles, ensembles triés. | Aucune prise en charge. Stockage de données brutes pré-sérialisées. |

| Taille des données | Valeurs jusqu’à 512 Mo. | Valeurs jusqu’à 1 Mo. |

| Prise en charge du stockage sur disque | Prise en charge native du stockage sur disque via RDB ou AOF. | Aucune prise en charge native. Nécessite des outils tiers. |

| Gestion des threads | Mono-thread. | Multi-thread. |

| Réplication | Architecture de réplication maître-esclave. | Ne prend pas en charge la réplication. |

| Eviction du cache | Stratégie LRU par défaut, d’autres stratégies sont configurables. | Stratégie LRU. |

| Langages de programmation | Prise en charge des principaux langages. | Prise en charge des principaux langages. |

Examinons maintenant les cas d’utilisation de Redis et Memcached.

Cas d’Utilisation de Redis et Memcached

#1. Servir le Commerce Électronique à Grande Échelle : Shopify

Si vous avez déjà envisagé de vendre en ligne, vous avez probablement croisé Shopify. Cette plateforme e-commerce multicanal permet de créer facilement une boutique en ligne. Au pic de son activité, Shopify traite 80 000 requêtes par seconde pour 600 000 marchands. La gestion d’un tel trafic avec des latences minimales constitue un défi de taille.

Pour y faire face, Shopify utilise Memcached et Redis dans son architecture technologique. L’architecture de Shopify est relativement simple : MySQL pour la base de données, Memcached pour le stockage clé-valeur et Redis pour les files d’attente. Il n’est pas toujours nécessaire de choisir entre Redis et Memcached. On peut les utiliser ensemble au sein d’une même architecture applicative.

Dans une plateforme e-commerce, vous trouvez de nombreuses données statiques qui ne sont pas mises à jour fréquemment. Il s’agit d’éléments comme les images des produits, les descriptions et les informations sur la boutique. Plutôt que de solliciter la base de données pour chaque requête, leur stockage dans un magasin clé-valeur accélère le système et améliore ses performances.

L’utilisation d’une solution de mise en cache comme Memcached pour la diffusion de contenu statique réduit la charge sur les serveurs dorsaux et les bases de données.

#2. Mise en Cache de Données Applicatives Distribuées : Pinterest

Pinterest est devenu un espace privilégié pour la recherche d’inspiration. Vous pouvez y consulter des épingles et des tableaux créés par d’autres personnes. Dans les coulisses, de nombreuses opérations sont réalisées. Chaque requête entrante passe par plusieurs services et implique une grande quantité de calculs. Cela inclut également l’analyse des épingles et des recommandations.

Afin de préserver les services dorsaux et d’éviter les calculs répétitifs, Pinterest utilise une couche de cache distribuée. Elle stocke les résultats de calculs récurrents. Les requêtes n’atteignent ainsi pas les services et bases de données coûteux en calcul ou en stockage. Le cache absorbe une part importante du trafic. La couche de mise en cache de Pinterest s’étend sur des milliers de machines et traite plus de 150 millions de requêtes par seconde.

Si on examine la manière dont Pinterest gère son cache, on constate qu’il utilise Memcached et mcrouter comme ossature. Grâce à sa nature asynchrone basée sur les événements et au traitement multi-thread, Memcached est particulièrement performant. De plus, son architecture simple permet de créer ses propres abstractions et de l’étendre horizontalement. C’est ainsi que Pinterest gère son trafic.

#3. Gestion de la Sécurité des Données à Grande Échelle : CloudSponge

Si vous cherchez un logiciel en tant que service (SaaS) permettant à vos utilisateurs d’envoyer facilement des invitations, des coupons ou des cartes de vœux, CloudSponge est la solution. Il permet d’importer les carnets d’adresses afin que les utilisateurs n’aient pas à saisir manuellement les adresses email des contacts.

En une année, CloudSponge traite près de 2 000 milliards d’adresses email via ses serveurs. Cela présente un défi en matière de sécurité, car toute vulnérabilité du système pourrait permettre à des pirates de dérober des données.

Redis peut être plus qu’une simple solution de mise en cache. C’est précisément ce que fait CloudSponge. Redis conserve toutes les données de contact en mémoire, juste le temps que les clients puissent les consulter. Ensuite, elles sont supprimées. Aucune donnée n’est conservée sur disque, même si Redis propose cette option.

#4. Autres Utilisations Courantes des Solutions de Mise en Cache

Voici quelques autres situations où les solutions de mise en cache sont couramment utilisées :

❇️ Systèmes de Messagerie Instantanée

Lors de la création d’un système de messagerie instantanée, les solutions de mise en cache sont essentielles. Elles permettent de stocker des données fréquemment consultées, comme les profils utilisateurs, les listes de contacts et les messages récents. Ceci permet de soulager la base de données et d’améliorer la réactivité du système.

Les fonctionnalités en temps réel comme les indicateurs de saisie et les notifications de présence bénéficient également de la mise en cache. L’utilisation d’un cache distribué permet d’étendre les serveurs dorsaux sans avoir besoin d’augmenter les caches.

❇️ Services de Localisation

Les applications de services basés sur la localisation (estimation de la distance, temps d’arrivée, recommandations à proximité) utilisent des caches optimisés pour les données de localisation. Ces données sont stockées sous la forme d’un index géospatial.

L’index géospatial permet de stocker la localisation de tout objet. Redis prend en charge les index géospatiaux par défaut. La transmission en mémoire de ces informations permet de les partager efficacement en temps réel.

❇️ Analyses en Temps Réel

Les jeux en ligne sont devenus un secteur majeur. Les jeux mobiles coopératifs ou les applications de sports fantastiques nécessitent des latences inférieures à la seconde afin de prendre des décisions ou d’apporter des modifications.

La mise en cache permet de réaliser des analyses en temps réel (gestion de classement par exemple). Pour les applications comme les sports fantastiques, vous pouvez stocker les statistiques et informations des joueurs dans le cache pour améliorer les performances de l’application.

Lequel Choisir ?

Redis se distingue comme une option polyvalente grâce à la gestion de diverses structures de données. Il s’adapte ainsi aux applications qui exigent davantage qu’une simple mise en cache. Ses latences inférieures à la milliseconde, son débit élevé, ainsi que la compatibilité avec les bibliothèques client des principaux langages de programmation en font un candidat de choix pour les systèmes exigeants en termes de vitesse et de flexibilité. Il offre également la possibilité de conserver les données sur disque.

Memcached excelle par sa simplicité et par la mise en cache à très grande vitesse. Il est idéal lorsque vous avez besoin de mettre en cache des données brutes et pré-sérialisées. Il tire efficacement parti de la mémoire disponible dans les différentes parties du système. L’architecture simple de Memcached se traduit par de très hautes performances, notamment sur les machines rapides avec réseau haut débit.

Le choix entre Redis et Memcached doit tenir compte de plusieurs facteurs : la complexité de votre application, les structures de données requises, et les besoins d’évolutivité. Redis convient aux cas nécessitant des structures de données variées et des fonctionnalités avancées, tandis que Memcached offre les latences les plus faibles et le débit le plus élevé dans des scénarios de mise en cache simples.

Au final, la décision entre Redis ou Memcached doit correspondre aux objectifs et contraintes spécifiques de votre projet. Il faut parfois aller au-delà de la mise en cache des données applicatives.

Découvrez comment configurer un serveur de mise en cache DNS local sous Linux.