De nouveaux mots à la mode et de nouveaux termes émergent presque quotidiennement à l’ère numérique. L’un de ces termes est l’informatique cognitive, qui gagne en popularité parmi les individus et les organisations.

Un système cognitif apprend le comportement humain et le raisonnement à grande échelle pour interagir naturellement avec eux. En termes simples, c’est un domaine de l’informatique qui vise à créer des machines intelligentes capables d’apprendre, de raisonner et de comprendre comme les humains.

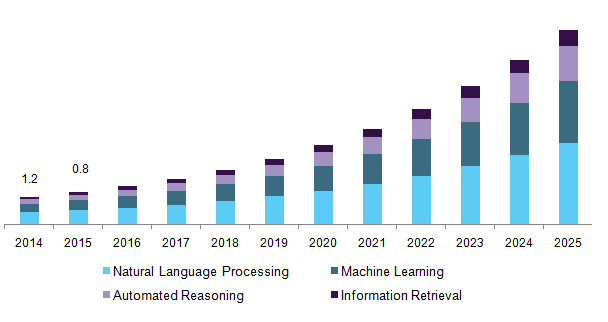

Les statistiques suggèrent que le marché de l’informatique cognitive, évalué à 25,6 milliards de dollars en 2021, devrait atteindre 269,4 milliards de dollars d’ici 2030 avec un TCAC de 29,7.

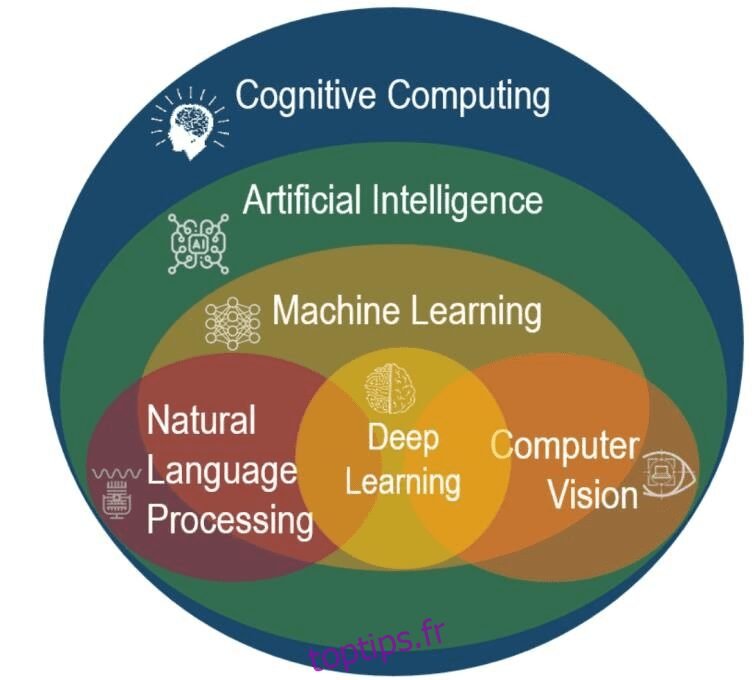

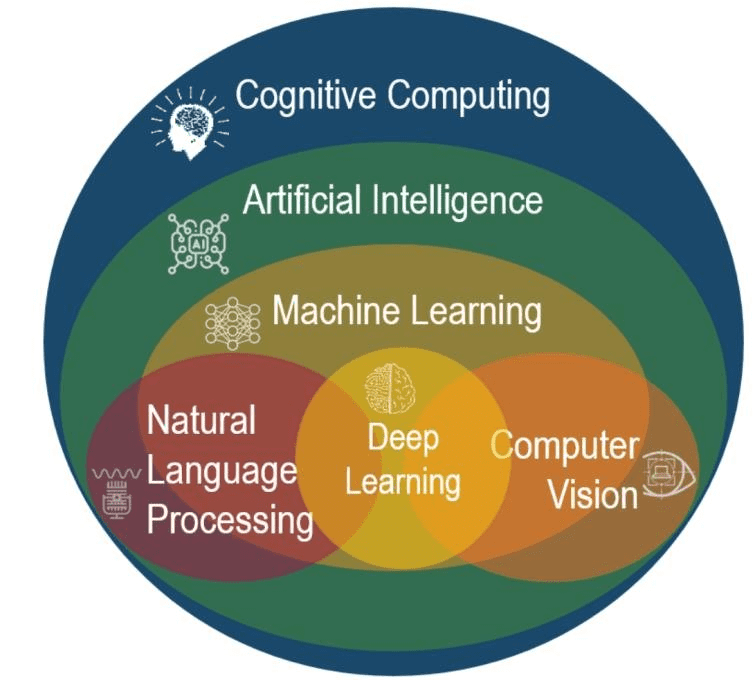

Les plates-formes d’informatique cognitive combinent l’apprentissage automatique (ML), le traitement du langage naturel (NLP), le raisonnement, l’interaction homme-machine, la reconnaissance de la parole et de la vision, et des technologies plus robustes pour simuler la pensée et l’interaction humaines et améliorer la prise de décision.

Dans ce blog, nous approfondirons notre compréhension de l’informatique cognitive. Nous verrons comment cela fonctionne, ses avantages, ses risques et plus encore.

Alors, lisez la suite pour en savoir plus sur cette technologie en croissance rapide.

Table des matières

Qu’est-ce que l’informatique cognitive ?

L’informatique cognitive est un ensemble de technologies individuelles qui exécutent des tâches particulières pour faciliter l’intelligence humaine.

En termes simples, l’informatique cognitive est un système qui comprend et interprète de grands volumes de données et les utilise pour prendre des décisions, résoudre des problèmes et améliorer les résultats commerciaux.

Il traite une grande quantité de données non structurées, telles que des images, du texte et des vidéos, pour extraire des informations précieuses et critiques et mieux analyser ces informations. La meilleure partie de l’informatique cognitive est qu’elle apprend et s’adapte à partir de l’expérience, améliorant ainsi ses capacités et ses performances avec le temps.

Ainsi, l’informatique cognitive aide à prendre de meilleures décisions humaines. Voici quelques applications essentielles de l’informatique cognitive :

- Systèmes de détection de fraude

- Reconnaissance de la parole

- Détection facial

- Assistants virtuels

- Analyse des sentiments

- L’évaluation des risques

- Moteurs de recommandation

Ainsi, les organisations peuvent prendre des décisions commerciales plus éclairées en tirant parti des informations et des recommandations intelligentes générées par l’informatique cognitive.

Comment fonctionne l’informatique cognitive ?

L’informatique cognitive combine les sciences cognitives et informatiques et crée des systèmes informatiques qui comprennent et apprennent du langage naturel et du raisonnement et prennent des décisions de type humain.

Et pour ce processus, l’informatique cognitive utilise diverses technologies avancées, telles que la PNL, le ML, l’exploration de données, la reconnaissance de formes et la vision par ordinateur, pour imiter les processus cognitifs de type humain.

Source : researchgate.net

Source : researchgate.net

L’objectif à long terme de l’informatique cognitive est de faciliter la création de modèles informatiques automatisés capables de résoudre des problèmes sans intervention humaine.

Voici une explication détaillée du fonctionnement de l’informatique cognitive :

- Ingestion de données : L’étape du processus du système informatique cognitif est la collecte et l’ingestion d’une énorme quantité de données non structurées et structurées provenant de plusieurs sources, telles que des capteurs, des bases de données, des médias sociaux et le Web.

- Traitement du langage naturel (NLP) : une fois les données ingérées, les systèmes informatiques cognitifs utilisent des algorithmes NLP pour extraire le contexte et la signification des données et comprendre le langage humain, y compris la syntaxe, la pragmatique et la sémantique.

- Apprentissage automatique (ML) : les systèmes informatiques cognitifs utilisent des algorithmes ML pour apprendre à partir des données extraites et concevoir des modèles pour le domaine du problème. Cela implique de former le système sur des données massives, d’analyser ses performances et d’améliorer continuellement le modèle en fonction des retours d’expérience.

- Algorithmes de raisonnement : une fois que l’informatique cognitive construit le modèle, elle utilise des algorithmes de raisonnement pour l’analyse des données et la prise de décisions basées sur les connaissances du modèle. Ce processus comprend l’utilisation du modèle construit pour déduire de nouvelles données et informations, identifier des modèles et prendre des décisions.

- Analyse de prédiction : les systèmes informatiques cognitifs évaluent la précision de leurs prédictions et ajustent leurs algorithmes et leurs modèles pour apprendre et améliorer en permanence leurs performances en fonction des commentaires des nouvelles données et des nouveaux utilisateurs.

- Interaction avec l’utilisateur : les systèmes informatiques cognitifs offrent une interface utilisateur qui permet aux utilisateurs d’interagir plus facilement avec les systèmes utilisant la PNL et de recevoir des recommandations et des informations basées sur l’analyse et le raisonnement du système.

Ainsi, l’informatique cognitive combine toutes les technologies avancées pour créer des systèmes qui interagissent avec les humains de manière intuitive et plus naturelle pour faciliter la prise de décision complexe basée sur la compréhension approfondie des données.

Principales caractéristiques de l’informatique cognitive

L’informatique cognitive fournit ces attributs et fonctionnalités clés pour donner un sens aux informations non structurées et faciliter la prise de décision complexe pour les humains.

- Apprentissage adaptatif : les systèmes informatiques cognitifs doivent être adaptatifs et capables d’apprendre rapidement des informations changeantes avec des exigences et des objectifs en constante évolution. Il traite en temps réel les données ambigües et dynamiques pour répondre aux besoins des données environnantes.

- Interactif : HCI ou Human-Computer Interaction est un composant essentiel des machines cognitives. Les utilisateurs doivent interagir avec les machines informatiques cognitives et définir leurs besoins changeants. De plus, l’informatique cognitive doit également interagir avec d’autres appareils, processus et plates-formes cloud.

- Avec état et itératif : les systèmes informatiques cognitifs doivent identifier les problèmes en extrayant des données supplémentaires et en posant des questions si la requête est incomplète ou vague. Les systèmes CC y parviennent en conservant des données et des informations sur des situations similaires déjà survenues.

- Contextuel : les systèmes informatiques cognitifs doivent facilement identifier, comprendre et extraire des informations contextuelles, telles que l’heure, le domaine, l’emplacement, les exigences ou le profil, les objectifs ou les tâches d’un utilisateur. Ils tirent des informations de plusieurs sources d’informations structurées et non structurées et de données sensorielles, visuelles et auditives.

Avantages de l’informatique cognitive

Voici les avantages essentiels de l’informatique cognitive pour les entreprises.

#1. Amélioration de la collecte et de l’interprétation des données

L’un des plus grands avantages de l’informatique cognitive est qu’elle analyse de vastes modèles de données et imite le comportement humain, comme l’apprentissage et la déduction et l’interprétation de données structurées et non structurées.

Cette analyse permet ensuite d’améliorer la visibilité du processus interne, d’augmenter les préférences et la fidélité des clients et l’accueil des produits et services.

#2. Détection des erreurs et dépannage

Lorsqu’ils sont appliqués à l’environnement technologique, les concepts d’informatique cognitive facilitent la détection précise et rapide des problèmes et des activités frauduleuses dans les processus métier et la découverte de solutions et d’opportunités commerciales.

#3. Prise de décision éclairée

Les capacités de collecte et d’analyse de données de l’informatique cognitive lui permettent de prendre des décisions plus stratégiques et éclairées, ce qui se traduit par des décisions financières plus intelligentes, des processus commerciaux beaucoup plus efficaces, une efficacité améliorée et des économies de coûts.

#4. Fidélisation de la clientèle

L’informatique cognitive offre une expérience client-technologie beaucoup plus informée et utile, stimulant l’interaction et la satisfaction client et améliorant la fidélisation de la clientèle.

#5. Cybersécurité améliorée

L’informatique cognitive peut aider les entreprises et les entreprises à identifier et à répondre aux activités cybercriminelles et aux menaces en ligne en temps réel à l’aide d’outils et de technologies d’analyse avancés.

L’informatique cognitive améliore la cybersécurité des entreprises des manières suivantes :

- Renseignements avancés sur les menaces

- Détection des menaces en temps réel

- Analyses prédictives

- Analyse comportementale

- Réponse automatisée aux incidents

Ainsi, les capacités informatiques cognitives aident les entreprises à prévenir de manière proactive les activités cybercriminelles et à réduire les menaces de sécurité potentielles et leurs dommages aux entreprises.

#6. Collaboration améliorée des employés

L’informatique cognitive aide les entreprises et les entreprises à améliorer la collaboration des employés en offrant des idées et des informations, permettant aux équipes de travailler beaucoup plus efficacement.

Comment l’informatique cognitive peut-elle améliorer l’expertise humaine ?

Dans certains domaines, les humains peuvent ne pas analyser de grandes quantités de données ou de problèmes qui peuvent ne pas être aussi évidents pour les humains.

C’est là que l’informatique cognitive joue un rôle plus important dans l’amélioration de l’expertise humaine en fournissant des technologies d’analyse avancées pour des résultats commerciaux plus excellents.

Voici comment l’informatique cognitive peut améliorer, accélérer et faire évoluer l’intelligence et l’expertise humaines :

- Il comprend le langage humain naturel grâce à des données sensorielles et interagit naturellement avec les humains, fournissant des conseils précis et impartiaux aux problèmes.

- Il identifie rapidement les risques potentiels à l’aide d’informations et d’analyses basées sur les données, permettant aux humains de prendre de meilleures décisions basées sur des preuves et des faits.

- Il aide les humains à résoudre des problèmes complexes et à résoudre leurs causes profondes tout en développant les bonnes solutions.

- Il contribue à améliorer l’efficacité opérationnelle en offrant un accompagnement progressif aux hommes et aux entreprises.

- L’informatique cognitive automatise les tâches banales et répétitives, libérant les ressources humaines et leur permettant de se concentrer sur des tâches plus complexes nécessitant une expertise humaine et des compétences uniques.

- Il aide à personnaliser l’expérience humaine en analysant les modèles de comportement et les préférences humaines pour fournir des recommandations et des suggestions hyper personnalisées.

Eh bien, beaucoup affirment que même l’intelligence artificielle ou les technologies d’intelligence artificielle aident à automatiser les processus répétitifs, à améliorer la personnalisation et à faciliter la vie des humains. En quoi l’informatique cognitive est-elle exactement différente de l’intelligence artificielle ? Découvrons-le.

Informatique cognitive Vs. Intelligence artificielle

Bien que les technologies derrière l’intelligence artificielle et l’informatique cognitive soient similaires, elles diffèrent dans leurs concepts, leur objectif et leurs capacités.

Voici les différences fondamentales entre l’informatique cognitive et l’intelligence artificielle.

Intelligence artificielleLe cas d’utilisation de base de l’informatique cognitive est la mise en œuvre du meilleur algorithme et l’augmentation de la pensée humaine pour résoudre des problèmes complexes. D’autre part, l’informatique cognitive se concentre sur l’imitation du comportement humain, de l’intelligence et du raisonnement pour résoudre des problèmes complexes. Les systèmes d’IA apprennent à partir des données pour trouver des modèles, faire des prédictions, révéler des informations cachées et prendre des mesures pour trouver une solution. Les systèmes informatiques cognitifs analysent un grand volume de données et comprennent et simulent le langage et le raisonnement humains naturels pour trouver des solutions aux problèmes. Les systèmes d’IA effectuent des tâches nécessitant une intelligence humaine, comme la reconnaissance vocale, la perception visuelle, le traitement du langage naturel et la prise de décision. Les systèmes informatiques cognitifs utilisent des modèles et des algorithmes inspirés du fonctionnement du cerveau humain, y compris l’apprentissage en profondeur et les réseaux de neurones. Les systèmes d’IA prennent des décisions par eux-mêmes, minimisant l’interférence et le rôle humains. L’informatique cognitive complète les données et les informations pour les humains afin de faciliter la prise de décision et la résolution de problèmes. L’IA est principalement utilisée dans les secteurs de la finance, de la banque, de la santé, de la sécurité, de la fabrication et de la vente au détail. L’informatique cognitive est principalement utilisée dans les secteurs du service client, de l’industrie et de la santé.

Ainsi, l’informatique cognitive est une approche plus spécifique de l’intelligence artificielle qui met l’accent sur le raisonnement et l’interaction de type humain.

Étant donné que l’informatique cognitive utilise le contexte de manière plus contextuelle en utilisant des informations fondées sur des preuves, cette technologie de la nouvelle ère devrait être la prochaine grande chose dans le monde vivant intelligent.

Source : dataversity.net

Source : dataversity.net

L’image suggère que le marché mondial de l’informatique cognitive atteindra 49,36 milliards de dollars d’ici 2025.

Cependant, comme chaque médaille a deux faces, l’informatique cognitive a ses propres risques et inconvénients, comme indiqué ci-dessous.

Risques et inconvénients de l’informatique cognitive

Voici quelques défis informatiques cognitifs rencontrés par les entreprises.

#1. Confidentialité et sécurité des données

Les systèmes informatiques cognitifs gèrent et s’appuient sur un grand volume de données, ce qui rend difficile le maintien d’une sécurité élevée des données et augmente les risques de violation de données et de violation de la vie privée.

Étant donné que les systèmes informatiques cognitifs doivent gérer un grand nombre de données sensibles, les organisations doivent prendre en compte et résoudre les violations de données et les problèmes de sécurité et élaborer un plan de sécurité des données à toute épreuve.

#2. Adoption

L’adoption est un problème avec toute nouvelle technologie.

Par conséquent, les organisations rationalisent le processus d’adoption pour assurer le succès de l’informatique cognitive en collaborant avec des parties prenantes telles que les développeurs de technologies, les organisations, les particuliers et le gouvernement.

#3. Processus de formation méticuleux

Les utilisateurs doivent suivre une formation approfondie sur les données pour bien comprendre le processus et le système d’informatique cognitive. Par conséquent, l’une des principales raisons de sa lente adoption est son processus de formation lent.

Chaque employé doit revoir le système informatique cognitif, ce qui rend le processus très complexe et coûteux.

#4. Manque de transparence

La complexité et la difficulté à comprendre les processus informatiques cognitifs créent un manque de transparence, ce qui rend difficile de comprendre comment le système est parvenu à une prédiction ou à une décision particulière.

#5. Biais

Les systèmes informatiques cognitifs apprennent à partir de données biaisées, ce qui entraîne des résultats et des résultats biaisés. Il en résulte une prise de décision discriminatoire et injuste, qui peut avoir des conséquences dans la vie réelle.

Par conséquent, former ces systèmes avec des informations impartiales et évaluer leurs capacités de prise de décision est essentiel.

#6. Interaction humaine

Bien que les systèmes informatiques cognitifs interagissent avec les humains pour comprendre le comportement et le raisonnement humains, ils sont toujours confrontés à des défis.

Les humains ont un large éventail de styles de communication, de dialectes et de langues, et essayer de raisonner avec eux peut souvent entraîner des malentendus, des erreurs et des informations incomplètes.

#7. Gestion du changement

Surmonter la gestion du changement est un autre défi informatique cognitif courant.

Le comportement humain naturel est que les humains sont généralement résistants au changement et aux nouveaux environnements. Malheureusement, l’informatique cognitive apprend cette capacité humaine, ce qui rend difficile pour ces systèmes de gérer le changement et augmente la crainte que les machines ne remplacent bientôt les humains.

#8. Dépendance à la qualité des données

La qualité des données utilisées par les systèmes informatiques cognitifs est cruciale pour leur efficacité et leur précision.

Des données biaisées, incomplètes ou inexactes affectent considérablement les performances et l’efficacité de ces systèmes.

#9. Long cycle de développement

Les systèmes informatiques cognitifs prennent beaucoup de temps pour développer des applications basées sur des scénarios. La mise en œuvre de solutions d’informatique cognitive dans plusieurs segments de l’industrie est un défi sans beaucoup de temps et sans les bonnes équipes de développement.

Les longs cycles de développement rendent difficile pour les petites organisations et les entreprises de développer leurs propres systèmes cognitifs.

#dix. Coût

Les systèmes informatiques cognitifs nécessitent beaucoup d’investissement en capital, d’expertise et d’infrastructure.

Par conséquent, les organisations doivent peser tous les avantages de l’informatique cognitive par rapport aux coûts avant d’investir dans des systèmes adaptés.

Ressources d’apprentissage

#1. Informatique cognitive : un bref guide pour les changeurs de jeu

Ce rapport concis et guide de l’informatique cognitive, publié par Peter Fingar, comprend l’essor de la technologie de l’informatique cognitive et des applications émergentes et leur impact sur les industries et les entreprises du monde entier.

L’auteur partage son parcours rapide et engageant avec les principaux événements, ressources et acteurs impliqués dans l’ère de l’informatique cognitive. C’est donc une lecture incontournable pour ceux qui ont besoin d’un aperçu approfondi de l’intelligence informatique cognitive et de la façon dont elle changera des vies à l’échelle mondiale.

#2. Informatique cognitive : théorie et applications (volume 35)

Ce guide complet et de premier ordre sur l’informatique cognitive se concentre sur sa théorie et ses applications. Il est écrit par des experts de renommée internationale, dont Vijay V Raghavan, Venu Govindaraju, Venkat N. Gudivada et CR Rao.

Cela comprend l’utilisation de systèmes informatiques cognitifs pour gérer les énergies renouvelables, les modèles et algorithmes d’apprentissage automatique, la biométrie, les algorithmes vocaux basés sur les données, l’analyse graphique et la cybersécurité.

#3. Informatique cognitive et analyse de mégadonnées

Ce livre aide les organisations et les technologues à comprendre les concepts et technologies sous-jacents de l’informatique cognitive, des algorithmes NLP aux techniques de représentation des connaissances.

Ce livre comprend également des implémentations réelles de projets émergents de Qualcomm, Google, Amazon et Hitachi.

#4. Recettes d’informatique cognitive

C’est l’un des livres idéaux pour les architectes d’entreprise et les ingénieurs logiciels qui souhaitent comprendre l’apprentissage en profondeur et résoudre leurs problèmes d’IA et de ML à l’aide d’exemples de code réels.

Publié par Adnan Massod et Adnan Hashmi, ce livre vous permet d’apprendre à créer des solutions prêtes pour la production à l’aide des API Microsoft Cognitive Services, à résoudre des problèmes d’entreprise en NLP et en vision par ordinateur et à appliquer l’apprentissage en profondeur à l’aide de Microsoft Cognitive Toolkit (CNTK) et TensorFlow. .

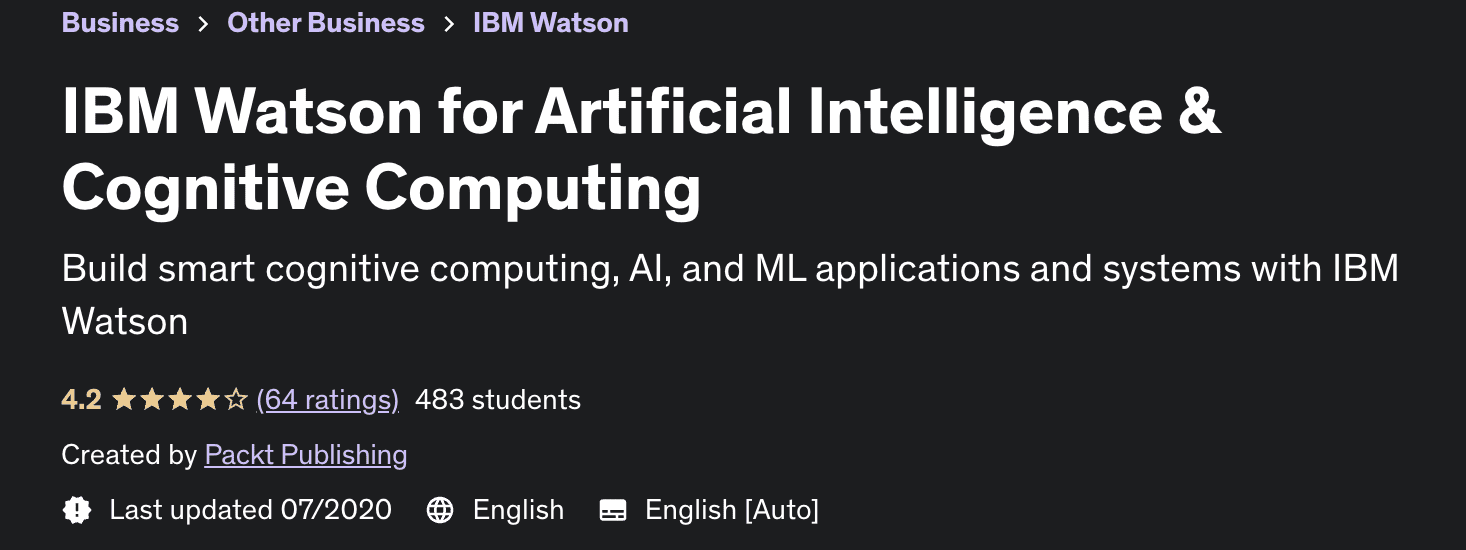

#5. IBM Watson pour l’intelligence artificielle et l’informatique cognitive

Ce cours Udemy est parfait si vous souhaitez apprendre à créer des systèmes et des applications intelligents d’IA, de ML et d’informatique cognitive avec IBM Watson.

Il explore les capacités de l’API IBM Watson pour choisir les meilleures fonctionnalités, créer un chatbot de cas client, extraire les métadonnées du texte et bien d’autres choses étonnantes.

Derniers mots

Alors que l’informatique cognitive n’a pas encore atteint son plein potentiel, sa mise en œuvre future offre de nombreuses possibilités. Par exemple, cela aide les humains à prendre de meilleures décisions, à automatiser les tâches redondantes et à décharger leur charge cognitive.

Ce blog vous aide à comprendre le concept d’informatique cognitive, son fonctionnement, ses avantages, et même sa portée et ses applications pour les organisations.

Ensuite, consultez les questions et réponses de l’entretien sur le cloud computing.