Il existe des téraoctets et des pétaoctets de données à l’ère d’Internet, avec une croissance exponentielle. Mais comment utilisons-nous ces données et les traduisons-nous en informations utiles pour améliorer la disponibilité des services ?

Des données valides, nouvelles et compréhensibles sont tout ce dont les entreprises ont besoin pour leurs modèles de découverte des connaissances.

Pour cette raison, les entreprises appliquent l’analyse de différentes manières pour découvrir des données de qualité.

Mais où tout commence-t-il ? La réponse est la lutte contre les données.

Commençons!

Table des matières

Qu’est-ce que le Data Wrangling ?

Le data wrangling consiste à nettoyer, structurer et transformer des données brutes dans des formats qui simplifient les processus d’analyse de données. La gestion des données implique souvent de travailler avec des ensembles de données désordonnés et complexes qui ne sont pas prêts pour les processus de pipeline de données. La gestion des données déplace les données brutes vers un état affiné ou les données affinées vers un état optimisé et un niveau prêt pour la production.

Certaines des tâches connues dans le traitement des données incluent :

- Fusion de plusieurs ensembles de données en un seul grand ensemble de données pour analyse.

- Examen des données manquantes/lacunes.

- Suppression des valeurs aberrantes ou des anomalies dans les ensembles de données.

- Normalisation des entrées.

Les grands magasins de données impliqués dans les processus de traitement des données vont généralement au-delà du réglage manuel, ce qui nécessite des méthodes automatisées de préparation des données pour produire des données plus précises et de qualité.

Objectifs de la lutte contre les données

Outre la préparation des données pour l’analyse en tant qu’objectif principal, les autres objectifs incluent :

- Créer des données valides et nouvelles à partir de données désordonnées pour orienter la prise de décision dans les entreprises.

- Normalisation des données brutes dans des formats que les systèmes Big Data peuvent ingérer.

- Réduire le temps passé par les analystes de données lors de la création de modèles de données en présentant des données ordonnées.

- Créer de la cohérence, de l’exhaustivité, de la convivialité et de la sécurité pour tout ensemble de données consommé ou stocké dans un entrepôt de données.

Approches courantes de la gestion des données

Découvrir

Avant de commencer les tâches de préparation des données, les ingénieurs de données doivent comprendre comment elles sont stockées, leur taille, les enregistrements conservés, les formats d’encodage et d’autres attributs décrivant tout ensemble de données.

Structuration

Ce processus implique l’organisation des données pour prendre des formats facilement utilisables. Les ensembles de données brutes peuvent nécessiter une structuration de la façon dont les colonnes apparaissent, le nombre de lignes et le réglage d’autres attributs de données pour simplifier l’analyse.

Nettoyage

Les ensembles de données structurés doivent être débarrassés des erreurs inhérentes et de tout ce qui peut fausser les données qu’ils contiennent. Le nettoyage implique donc de supprimer plusieurs entrées de cellule avec des données similaires, de supprimer les cellules vides et les données aberrantes, de normaliser les entrées, de renommer les attributs confus, etc.

Enrichissant

Une fois que les données ont passé les étapes de structuration et de nettoyage, il est nécessaire d’évaluer l’utilité des données et de l’augmenter avec des valeurs d’autres ensembles de données qui manquent pour donner la qualité de données souhaitée.

Validation

Le processus de validation implique des aspects de programmation itératifs qui mettent en lumière la qualité, la cohérence, la convivialité et la sécurité des données. La phase de validation garantit que toutes les tâches de transformation sont réalisées et signale que les ensembles de données sont prêts pour les phases d’analyse et de modélisation.

En présentant

Une fois toutes les étapes franchies, les ensembles de données mélangés sont présentés/partagés au sein d’une organisation à des fins d’analyse. La documentation des étapes de préparation et les métadonnées générées tout au long du processus de discussion sont également partagées à ce stade.

Talend

Talend est une plateforme unifiée de gestion des données enveloppée dans 3 data fabrics pour fournir des données fiables et saines. Talend présente l’intégration de données, l’application et l’intégration, et l’intégrité et la gouvernance des données. La gestion des données dans Talend s’effectue via un outil pointer-cliquer basé sur un navigateur qui permet les préparations de données par lots, en bloc et en direct – profilage, nettoyage et documentation des données.

Talend Data Fabric gère chaque étape du cycle de vie des données, en équilibrant soigneusement la disponibilité des données, l’utilisabilité, la sécurité et l’intégrité de chaque donnée métier.

Avez-vous déjà été préoccupé par vos diverses sources de données ? L’approche unifiée de Talend permet une intégration rapide des données à partir de toutes vos sources de données (bases de données, stockages cloud et endpoints d’API) – permettant la transformation et le mappage de toutes les données avec des contrôles de qualité transparents.

L’intégration de données dans Talend est activée via des outils en libre-service tels que des connecteurs qui permettent aux développeurs d’ingérer automatiquement des données de n’importe quelle source et de catégoriser les données de manière adéquate.

Fonctionnalités de Talend

Intégration universelle des données

Talend permet aux entreprises de gérer n’importe quel type de données à partir de sources de données variées – environnements cloud ou sur site.

Flexible

Talend va au-delà du fournisseur ou de la plate-forme lors de la création de pipelines de données à partir de vos données intégrées. Une fois que vous avez créé des pipelines de données à partir de vos données ingérées, Talend vous permet d’exécuter les pipelines n’importe où.

Qualité des données

Grâce à des fonctionnalités de machine learning telles que la déduplication, la validation et la standardisation des données, Talend nettoie automatiquement les données ingérées.

Prise en charge des intégrations d’applications et d’API

Une fois que le sens est donné à vos données via les outils en libre-service de Talend, vous pouvez partager vos données via des API conviviales. Les endpoints de l’API Talend peuvent exposer vos actifs de données aux plateformes SaaS, JSON, AVRO et B2B grâce à des outils avancés de mappage et de transformation des données.

R

R est un langage de programmation bien développé et efficace pour aborder l’analyse exploratoire des données pour les applications scientifiques et commerciales.

Conçu comme un logiciel libre pour le calcul statistique et les graphiques, R est à la fois un langage et un environnement pour la manipulation, la modélisation et la visualisation de données. L’environnement R fournit une suite de progiciels tandis que le langage R intègre une série de techniques statistiques, de regroupement, de classification, d’analyse et graphiques qui aident à manipuler les données.

Caractéristiques de R

Riche ensemble de packages

Les ingénieurs de données disposent de plus de 10 000 packages et extensions standardisés à sélectionner dans le Comprehensive R Archive Network (CRAN). Cela simplifie les querelles et l’analyse des données.

Extrêmement puissant

Avec les packages informatiques distribués disponibles, R peut effectuer des manipulations complexes et simples (mathématiques et statistiques) sur des objets de données et des ensembles de données en quelques secondes.

Prise en charge multiplateforme

R est indépendant de la plate-forme, capable de fonctionner sur de nombreux systèmes d’exploitation. Il est également compatible avec d’autres langages de programmation qui aident à manipuler des tâches de calcul lourdes.

Apprendre R est facile.

Trifacta

Trifacta est un environnement cloud interactif pour le profilage des données exécutées sur des modèles d’apprentissage automatique et d’analyse. Cet outil d’ingénierie de données vise à créer des données compréhensibles, quel que soit le désordre ou la complexité des ensembles de données. Les utilisateurs peuvent supprimer les doubles entrées et remplir les cellules vides des ensembles de données grâce à la déduplication et aux transformations linéaires.

Cet outil de gestion des données a un œil sur les valeurs aberrantes et les données invalides dans n’importe quel ensemble de données. D’un simple clic et glissement, les données disponibles sont classées et transformées intelligemment à l’aide de suggestions alimentées par l’apprentissage automatique pour accélérer la préparation des données.

La gestion des données dans Trifacta se fait par le biais de profils visuels convaincants pouvant accueillir du personnel non technique et technique. Avec les transformations visualisées et intelligentes, Trifacta est fier de sa conception pour les utilisateurs.

Qu’il s’agisse d’ingérer des données provenant de data marts, d’entrepôts de données ou de lacs de données, les utilisateurs sont protégés de la complexité de la préparation des données.

Caractéristiques de Trifacta

Intégrations cloud transparentes

Prend en charge les charges de travail de préparation dans n’importe quel environnement cloud ou hybride pour permettre aux développeurs d’ingérer des ensembles de données pour les disputes, peu importe où ils vivent.

Méthodes de normalisation de données multiples

Trifacta wrangler dispose de plusieurs mécanismes pour identifier des modèles dans les données et normaliser les sorties. Les ingénieurs de données peuvent choisir la normalisation par modèle, par fonction ou mélanger et assortir.

Flux de travail simple

Trifacta organise les travaux de préparation des données sous forme de flux. Un flux contient un ou plusieurs ensembles de données ainsi que leurs recettes associées (étapes définies qui transforment les données).

Un flux réduit donc le temps passé par les développeurs lors de l’importation, de la manipulation, du profilage et de l’exportation des données.

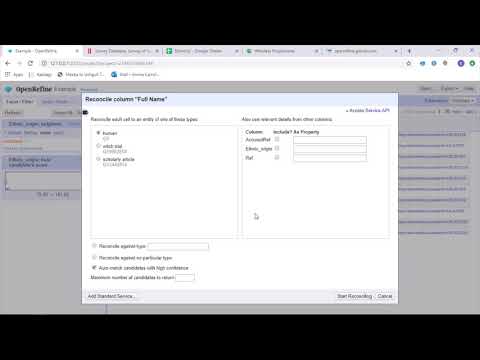

OuvrirAffiner

OuvrirAffiner est un outil mature et open source pour travailler avec des données désordonnées. En tant qu’outil de nettoyage des données, OpenRefine explore les ensembles de données en quelques secondes tout en appliquant des transformations de cellules complexes pour présenter les formats de données souhaités.

OpenRefine aborde la gestion des données via des filtres et des partitions sur des ensembles de données à l’aide d’expressions régulières. À l’aide du langage General Refine Expression Language intégré, les ingénieurs de données peuvent apprendre et afficher les données à l’aide de facettes, de filtres et de techniques de tri avant d’effectuer des opérations de données avancées pour les extractions d’entités.

OpenRefine permet aux utilisateurs de travailler sur des données en tant que projets où des ensembles de données provenant de plusieurs fichiers informatiques, URL Web et bases de données peuvent être extraits dans de tels projets avec la possibilité de s’exécuter localement sur les machines des utilisateurs.

Grâce aux expressions, les développeurs peuvent étendre le nettoyage et la transformation des données à des tâches telles que le fractionnement/la jonction de cellules à plusieurs valeurs, la personnalisation des facettes et la récupération de données dans des colonnes à l’aide d’URL externes.

Fonctionnalités d’OpenRefine

Outil multiplateforme

OpenRefine est conçu pour fonctionner avec les systèmes d’exploitation Windows, Mac et Linux via des configurations d’installation téléchargeables.

Riche ensemble d’API

Comprend l’API OpenRefine, l’API d’extension de données, l’API de réconciliation et d’autres API qui prennent en charge l’interaction des utilisateurs avec les données.

Datameer

Datameer est un outil de transformation de données SaaS conçu pour simplifier la gestion et l’intégration des données via des processus d’ingénierie logicielle. Datameer permet l’extraction, la transformation et le chargement d’ensembles de données dans des entrepôts de données Cloud tels que Snowflake.

Cet outil de gestion des données fonctionne bien avec les formats d’ensembles de données standard tels que CSV et JSON, permettant aux ingénieurs d’importer des données dans des formats variés pour l’agrégation.

Datameer propose une documentation des données de type catalogue, un profilage approfondi des données et une découverte pour répondre à tous les besoins de transformation des données. L’outil conserve un profil de données visuel approfondi qui permet aux utilisateurs de suivre les champs et les valeurs non valides, manquants ou périphériques, ainsi que la forme générale des données.

S’exécutant sur un entrepôt de données évolutif, Datameer transforme les données pour des analyses significatives grâce à des piles de données efficaces et à des fonctions de type Excel.

Datameer présente une interface utilisateur hybride, codée et sans code pour accueillir de vastes équipes d’analyse de données qui peuvent facilement créer des pipelines ETL complexes.

Fonctionnalités de Datameer

Environnements multi-utilisateurs

Comprend des environnements de transformation de données multi-personnes – low code, code et hybride, pour prendre en charge les personnes férus de technologie et non techniques.

Espaces de travail partagés

Datameer permet aux équipes de réutiliser et de collaborer sur des modèles pour accélérer les projets.

Documentation riche en données

Datameer prend en charge la documentation des données générées par le système et par l’utilisateur via des métadonnées et des descriptions, des balises et des commentaires de style wiki.

Derniers mots 👩🏫

L’analyse de données est un processus complexe, qui nécessite que les données soient organisées de manière appropriée pour tirer des conclusions significatives et faire des prédictions. Les outils de Data Wrangling vous aident à formater de grandes quantités de données brutes pour vous aider à effectuer des analyses avancées. Choisissez le meilleur outil qui correspond à vos besoins et devenez un pro de l’analyse !

Tu peux aimer:

Meilleurs outils CSV pour convertir, formater et valider.