La transformation numérique de votre entreprise ne peut être pleinement réalisée tant que les données éparses ne sont pas centralisées au sein d’une structure unifiée. Cette structure doit faciliter la conformité aux politiques de gestion des risques, de gouvernance et de confidentialité, tout en assurant un traitement efficace des informations.

Fréquemment, les organisations composées d’équipes et de services distincts collectent et gèrent leurs données de manière isolée. Les contraintes de gouvernance et de confidentialité des données constituent également un frein à la fusion de divers ensembles de données, qu’ils soient publics ou privés.

Alors, quelle approche adopter pour un traitement véritablement centralisé et dématérialisé des données ? La réponse réside dans le concept de « Data Fabric ». Poursuivez votre lecture pour en explorer les rouages et prendre des décisions éclairées lors de l’acquisition d’un outil Data Fabric.

Qu’est-ce qu’un Data Fabric ?

Le « tissu de données » ou Data Fabric est apparu comme l’une des dix principales tendances technologiques en 2019, d’après un rapport de Gartner. Les experts en analyse et technologies de données le considèrent comme une solution incontournable pour la gestion des données, que ce soit pour les startups technologiques, les PME ou les grandes entreprises.

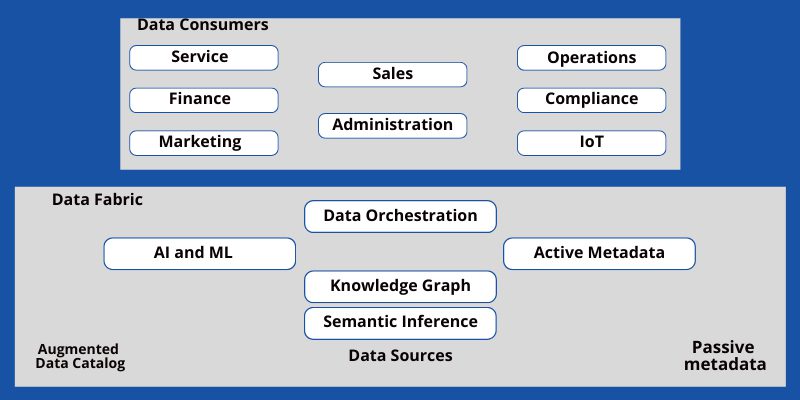

Il s’agit d’un environnement informatique basé sur une architecture harmonisée, connectant différentes sources de données aux applications métiers. En arrière-plan, un puissant moteur d’intelligence artificielle (IA) analyse les données de manière sécurisée et ne présente que les informations pertinentes à un commercial, un agent du service client ou un responsable.

Vu de haut, le Data Fabric se présente comme une trame virtuelle où se connectent et partagent des informations divers systèmes de stockage et de traitement de données.

L’objectif d’un Data Fabric

Les obstacles posés par la diversité des applications métiers, les contraintes de temps et d’espace, les différences en matière de stockage, de méthodes de récupération, de protocoles de sécurité des données, etc., constituent des freins majeurs qui entravent la progression de l’entreprise. Bien que ces mécanismes contribuent à sécuriser les données confidentielles, ils ne peuvent être ni supprimés, ni maintenus en l’état.

C’est là qu’intervient le Data Fabric. Il agit comme une autoroute facilitant la circulation des données provenant de diverses installations, applications métiers, bureaux distants, points de vente, serveurs, et bien d’autres sources. De plus, ces données peuvent être structurées, semi-structurées ou brutes. N’oublions pas que différents types de données impliquent des niveaux de sécurité variés.

L’utilisateur final, qu’il s’agisse d’un client, d’un commercial, d’un support ou d’un responsable, n’a pas besoin de comprendre tous ces détails. Il lui suffit d’accéder aux données pertinentes en toute sécurité pour accomplir ses tâches. Le Data Fabric permet de répondre à cette exigence grâce à l’automatisation, l’intelligence artificielle et l’apprentissage automatique (ML).

Les objectifs notables supplémentaires sont :

- Connecter toutes les sources de données de l’entreprise via des conteneurs et des connecteurs

- Offrir des capacités d’intégration et d’ingestion des données vers les systèmes de stockage, les applications, etc.

- Servir d’infrastructure de données à haute performance pour l’analyse du Big Data

- Rassembler les consommateurs et les sources de données sur un réseau maillé unique

- Assurer des opérations de données hybrides entre les clouds privés, publics, multi-clouds, les postes de travail sur site et bare metal

Actuellement, les entreprises consacrent davantage de temps à la décision et à l’approbation des données qu’à leur traitement. Les employés doivent souvent traverser d’innombrables échanges de courriels avant d’obtenir les autorisations nécessaires pour accéder aux données.

Cette situation constitue une menace sérieuse pour la productivité des entreprises tournées vers l’avenir. Or, le Data Fabric peut pallier ce problème de différentes manières :

- Plateforme centralisée pour accéder, soumettre, conserver et analyser tous types de données.

- Bien que l’accès aux données soit possible à différents niveaux au sein de l’entreprise, toutes les politiques de gouvernance et de réglementation des données sont respectées.

- Les IA traitent les données avant qu’elles ne soient accessibles aux humains, ce qui les rend plus fiables et faciles à interpréter.

- Faciliter la communication de machine à machine ou l’Internet des Objets (IoT) pour réduire l’intervention humaine dans le traitement des données sensibles.

- S’adapter facilement aux fluctuations des applications, des demandes des clients, des tickets d’accès aux données internes, des afflux massifs de données marketing, etc.

- Réduire les besoins de l’entreprise en matière d’infrastructure et, par conséquent, les coûts associés.

- Tirer le meilleur parti des technologies cloud en connectant toutes sortes de sources de données numériques au sein d’un environnement unique, sécurisé par des algorithmes d’IA performants.

En fin de compte, les employés de première ligne peuvent accéder plus rapidement aux données dans leurs CRM et traiter les demandes clients avec plus d’efficacité. Cela permet d’accroître la confiance et la satisfaction des clients envers votre entreprise.

Avantages du Data Fabric

Renforce le modèle Agile DevOps

Les projets de développement de logiciels ou de produits agiles peuvent être perturbés par des problèmes de traitement de données intermittents. En adoptant un outil Data Fabric, il est possible de supprimer quasiment toutes les interruptions liées aux données.

Conformité à la gouvernance des données

L’IA et le ML sous-jacents contribuent à l’application des politiques de confidentialité et de gouvernance des données. Ainsi, le même algorithme d’IA traite les données demandées et les présente à un employé dans le respect des règles établies par l’entreprise.

Scalabilité

Les fournisseurs de services gérés (MSP) peuvent ajuster instantanément les capacités de traitement de données en fonction de vos besoins.

Gestion des métadonnées

Un catalogue d’analyse de données héberge les sources de données, les actifs et les métadonnées. L’analyse des métadonnées permet à l’IA d’extraire les données nécessaires avec une plus grande rapidité.

Détection des erreurs

L’IA peut détecter la corruption, les problèmes d’intégrité et les erreurs avant que l’entreprise ne subisse des pertes de revenus.

Accès basé sur les rôles

Les employés peuvent demander l’accès aux données traitées en fonction de leurs habilitations de sécurité au sein de l’organisation.

Suppression des silos de données

Les silos de données ne peuvent plus menacer l’entreprise lorsque le Data Fabric amène toutes les informations sur une voie de données sécurisée. Les équipes peuvent accéder aux données légitimes de chaque service sans devoir passer par des étapes intermédiaires.

Intégration des données

Le Data Fabric et son IA sous-jacente permettent une intégration instantanée des données avec des logiciels en temps réel comme les CRM, les ERP, les applications clients, les applications des employés de première ligne, etc.

Données de haute qualité

Les algorithmes intelligents d’un outil Data Fabric analysent en permanence toutes les sources de données. Par conséquent, les employés peuvent se fier aux données traitées sans avoir à les valider auprès de leurs supérieurs.

L’architecture d’un Data Fabric

Un Data Fabric doit assurer une accessibilité accrue aux données sans compromettre la qualité et la sécurité. Par conséquent, une architecture standard de Data Fabric doit comprendre les composants suivants :

Catalogue de données

Un catalogue de données constitue une forme organisée de toutes les données de l’entreprise. Les utilisateurs peuvent y accéder pour trouver les informations nécessaires à l’exécution de leurs tâches. Le catalogue de données est composé des sous-éléments suivants : les métadonnées et le graphe de connaissances.

Automatisation basée sur l’IA et le ML

Une multitude d’IA doit être au cœur du Data Fabric afin de gérer toutes les résolutions de requêtes, le contrôle qualité, les contrôles de sécurité, etc.

Intégration et transport des données

Les Data Fabrics intègrent les données issues de toutes les sources, telles que les serveurs sur site, le stockage cloud, les ordinateurs portables des employés, etc. Des connecteurs de données sont indispensables pour relier les informations à un ordinateur ou à un transporteur distant, afin de permettre la circulation des données au sein du Data Fabric.

Comment implémenter un Data Fabric

La méthode d’implémentation dépendra de la nature de votre organisation et de ses besoins spécifiques. En raison de la diversité des exigences des entreprises, il n’existe pas de solution unique pour déployer un Data Fabric. Cependant, on retrouve certaines caractéristiques ou couches communes dans l’architecture d’un Data Fabric.

Gestion des données : Cette couche est dédiée à la sécurité et à la gouvernance des données.

Ingestion des données : Cette couche est chargée de rassembler toutes les données cloud, tout en identifiant les liens entre les données structurées et non structurées.

Traitement des données : Cette étape assure que les données pertinentes sont accessibles lors de l’extraction.

Organisation des données : Cette couche comprend l’exécution de tâches telles que la collecte des données en silo, leur structuration, leur nettoyage, leur intégration et leur transformation, afin de les rendre utilisables.

Découverte des données : Cette étape permet de collecter les données en intégrant diverses sources. C’est un élément crucial pour la satisfaction des clients.

Accès aux données : Cette couche est dédiée à la consommation des données. Elle facilite l’accès aux données pertinentes via des outils de visualisation de données ou des tableaux de bord d’application.

Principes du Data Fabric

Le concept des Data Fabrics vise à unifier les actifs de données distribués et diversifiés des entreprises de tous les secteurs. De plus, il combine les processus de gestion des données de bout en bout au sein d’une plateforme de gestion de données unifiée.

Le Data Fabric atteint ces objectifs en s’appuyant sur les principes de gestion de données suivants :

- Découverte des données

- Conservation des données

- Organisation des données

- Modélisation des données

- Contrôle qualité

- Orchestration des données en silo

- Intégration des données

- Gouvernance des données

Capacités du Data Fabric

Résolution continue des requêtes de données

Les Data Fabrics s’appuient sur l’Internet haut débit, les disques SSD et les superordinateurs pour extraire en permanence les données demandées sans aucune interruption de service.

Intégration, découverte et catalogage continus des données

L’IA centrale responsable de la gestion des données au sein du Data Fabric doit fonctionner en continu pour accepter les nouvelles données brutes, les analyser, les cataloguer et les intégrer dans les applications métier.

Métadonnées passives et actives

Les métadonnées actives comprennent des informations telles que la qualité des données, l’utilisation des données, l’éditeur actuel, etc. Les métadonnées passives, quant à elles, sont des données statiques annoncées par l’auteur. L’IA du Data Fabric modifie ces métadonnées en permanence afin de réduire les efforts manuels d’exploration ou de préparation des données.

Flexibilité

Le Data Fabric est extrêmement flexible et s’adapte aux changements en fonction des besoins de l’entreprise.

La mise en œuvre d’un Data Fabric est simplifiée grâce à l’utilisation de logiciels spécialisés. Plusieurs options existent, mais les outils suivants sont particulièrement adaptés aux petites et moyennes entreprises :

Atlan

Atlan est une plateforme de métadonnées actives performante et facile à utiliser, ainsi qu’un espace de travail de données qui facilite l’accès aux données issues de diverses sources. Il fonctionne comme un catalogue de données moderne pour vos besoins en matière de Data Fabric. La plateforme offre des solutions pour la gestion des données, notamment le catalogage, le profilage, la découverte, la qualité, la gouvernance, l’exploration et l’intégration.

L’interface utilisateur intuitive s’inspire de la recherche Google. Le glossaire métier riche permet de mieux comprendre vos données. Les entreprises peuvent utiliser des fonctionnalités telles que la gouvernance granulaire et les contrôles d’accès pour gérer l’utilisation des données dans un écosystème.

De plus, Atlan prend en charge l’intégration avec des applications telles que Big Query, Amazon Redshift, Snowflake, MYSQL, Looker et Tableau.

K2View

Si vous recherchez une plateforme offrant une fonctionnalité de Data Fabric de bout en bout, K2View est un excellent choix. Cette application de gestion des données vous assiste à chaque étape du processus, notamment l’intégration, la préparation, l’orchestration et le pipeline de données.

Grâce à cet outil, les entreprises peuvent activer des architectures de Data Fabric sophistiquées dans des environnements cloud, sur site et hybrides. L’automatisation de la gestion des données facilitera le déploiement du Data Fabric. K2View peut unifier les données de multiples sources et les acheminer vers des systèmes cibles, en garantissant l’intégrité des informations.

Avec K2View, vous pouvez créer instantanément des Data Lakes et des entrepôts de données, que vous pouvez analyser sans délai. Même sans connaissances en codage, vous avez la possibilité de contrôler les déplacements et les transformations de données de la source à la cible.

Les entreprises peuvent également configurer des règles pour contrôler l’accès, la synchronisation et la sécurité des données. De plus, cet outil convient à l’automatisation des services de données grâce à son cadre intuitif.

Talend

Talend est une plateforme de Data Fabric qui garantit un accès sécurisé aux données, tout en contribuant à la création de valeur pour l’entreprise. Toute entreprise doit pouvoir gérer des données complètes et fiables, en veillant à leur convivialité, leur intégrité, leur disponibilité et leur sécurité. Cette application permet aux organisations de préserver la qualité des données en réduisant les risques.

Talend est une plateforme unifiée pour les données fiables et accessibles, offrant des fonctionnalités de gouvernance, d’intégration et d’intégrité. Elle fournit des données de haute qualité à l’aide d’une infrastructure de services et d’écosystèmes de partenaires. La documentation et la catégorisation permettent d’identifier rapidement les données pertinentes.

Comme elle nettoie automatiquement les données en temps réel, il n’y a aucun risque que des données erronées n’intègrent votre système. Les entreprises peuvent améliorer leur productivité et réaliser des économies grâce à cet outil qui garantit la conformité réglementaire et réduit les risques.

L’utilisation de cette application et de son intégration API permet d’offrir de meilleures expériences aux clients. De plus, les fonctionnalités en libre-service facilitent le partage de données fiables, en interne comme en externe.

Incorta

Incorta est une plateforme d’analyse de données en libre-service, où les entreprises peuvent exploiter pleinement le potentiel de leurs données pour obtenir des informations à moindre coût. Cette solution permet une expérience de données plus agile, pour des prises de décisions éclairées et opportunes.

Incorta utilise des fonctionnalités d’analyse en mémoire et de cartographie directe des données, ce qui garantit une rapidité et une évolutivité optimales pour le stockage et la gestion des données. Même si vous souhaitez analyser des données issues de sources multiples, Incorta garantit une véritable agilité métier et un pipeline de données flexible.

En outre, cet outil permet de collecter, traiter, analyser et présenter les données issues d’applications métiers. La fonction de visualisation native vous permet de présenter les données de l’entreprise de manière fidèle.

Conclusion

Le Data Fabric représente l’architecture de nouvelle génération pour le stockage, le traitement, la sauvegarde et la gestion des données. Bien qu’il s’agisse d’une application informatique tournée vers l’avenir, de nombreuses entreprises numériques utilisent déjà des outils de Data Fabric pour préparer leur personnel aux défis de demain.

Les petites entreprises, les moyennes entreprises et les startups peuvent tirer le plus de bénéfices de cette technologie, car elles ne peuvent se permettre aucun retard dans leur flux de travail causé par des procédures d’approbation ou d’examen fastidieuses. Nous vous encourageons à explorer les outils mentionnés ci-dessus afin d’étudier leurs offres et leur valeur ajoutée pour votre entreprise.

Votre modèle commercial RevOps peut grandement bénéficier d’un Data Fabric. Apprenez-en davantage sur les outils d’opérations de revenus (RevOps).