Comprendre l’importance de l’analyse des fichiers journaux pour le SEO

L’examen des fichiers journaux SEO est crucial pour décrypter le comportement des robots d’exploration sur votre site web. Cela permet d’identifier des opportunités techniques pour optimiser votre stratégie SEO.

Ignorer l’analyse du comportement des robots d’exploration revient à naviguer à l’aveugle en SEO. Bien que vous ayez pu soumettre votre site à Google Search Console et l’avoir fait indexer, sans l’étude des fichiers journaux, il est impossible de savoir si votre site est exploré et interprété correctement par les moteurs de recherche.

C’est pour cette raison que j’ai compilé un guide complet sur l’analyse des fichiers journaux SEO. Vous y découvrirez comment identifier les problèmes et les opportunités d’amélioration pour votre référencement.

Qu’est-ce que l’analyse des fichiers journaux ?

L’analyse des fichiers journaux SEO est un processus qui consiste à décortiquer les schémas d’interaction entre les robots d’indexation des moteurs de recherche et votre site. C’est un élément fondamental du référencement technique.

L’audit des fichiers journaux est essentiel pour que les spécialistes SEO puissent identifier et résoudre les problèmes liés à l’exploration, à l’indexation et aux codes d’état.

Que sont les fichiers journaux ?

Les fichiers journaux enregistrent l’activité des visiteurs d’un site web et les contenus qu’ils consultent. Ils contiennent des informations sur l’entité (appelée « client ») qui a sollicité l’accès au site.

Ces informations peuvent concerner les robots des moteurs de recherche, tels que Google ou Bing, ou les visiteurs humains. Les serveurs web du site collectent et conservent ces enregistrements, généralement pour une durée limitée.

Que contient un fichier journal ?

Avant de comprendre l’importance des fichiers journaux pour le SEO, il est essentiel de savoir ce qu’ils contiennent. Un fichier journal inclut généralement les données suivantes :

- L’URL de la page sollicitée par le visiteur

- Le code d’état HTTP de la page

- L’adresse IP du serveur sollicité

- La date et l’heure de la requête

- Les données de l’agent utilisateur (robot du moteur de recherche) effectuant la requête

- La méthode de requête (GET/POST)

Les fichiers journaux peuvent sembler complexes au premier abord. Cependant, une fois que vous comprenez leur utilité et leur importance pour le SEO, vous pourrez les exploiter efficacement pour obtenir des informations précieuses.

Objectifs de l’analyse des fichiers journaux pour le SEO

L’analyse des fichiers journaux est un outil puissant pour identifier et résoudre des problèmes techniques de référencement importants. Elle vous permet d’affiner votre stratégie SEO pour optimiser votre site.

Voici quelques problèmes de référencement qui peuvent être analysés à l’aide des fichiers journaux :

#1. Fréquence d’exploration du site par Googlebot

Les robots d’exploration doivent visiter fréquemment vos pages les plus importantes pour que le moteur de recherche soit informé de vos mises à jour ou de nouveaux contenus.

Toutes vos pages de produits et les informations cruciales doivent apparaître dans les journaux de Google. L’absence d’une page de catégorie importante ou la présence d’une page produit que vous ne vendez plus sont des indicateurs de problèmes qui peuvent être identifiés via l’analyse des fichiers journaux.

Comment un robot de moteur de recherche utilise-t-il le budget d’exploration ?

Chaque robot d’exploration dispose d’un budget d’exploration limité lorsqu’il visite votre site. Google définit ce budget comme la somme du taux d’exploration et de la demande d’exploration d’un site.

Si votre site contient de nombreuses URL de faible valeur ou des URL mal soumises dans votre sitemap, cela peut entraver son exploration et son indexation. L’optimisation de votre budget d’exploration facilite l’exploration et l’indexation de vos pages clés.

L’analyse des fichiers journaux vous permet d’optimiser votre budget d’exploration et d’améliorer vos efforts SEO.

#2. Problèmes et état de l’indexation mobile-first

L’indexation mobile-first est désormais essentielle pour tous les sites web, et Google la privilégie. L’analyse des fichiers journaux vous indique la fréquence à laquelle Googlebot version smartphone parcourt votre site.

Cette analyse permet aux webmasters d’optimiser les versions mobiles de leurs pages si elles ne sont pas correctement explorées par Googlebot pour smartphone.

#3. Codes d’état HTTP renvoyés par les pages web

Les codes de réponse générés par vos pages web peuvent être récupérés via l’analyse des fichiers journaux ou via l’outil d’inspection d’URL de Google Search Console.

Les analyseurs de fichiers journaux peuvent identifier les pages avec des codes 3xx, 4xx et 5xx. Vous pouvez résoudre ces problèmes en redirigeant correctement les URL ou en changeant un état 302 en 301.

#4. Analyse des activités d’exploration telles que la profondeur de crawl et les liens internes

Google évalue la structure de votre site en fonction de sa profondeur d’exploration et de ses liens internes. Une mauvaise structure de liens internes ou une profondeur d’exploration inadéquate peuvent nuire à l’exploration du site.

L’analyse des fichiers journaux est précieuse pour détecter les problèmes liés à la hiérarchie ou à la structure de votre site, ainsi qu’à vos liens internes.

L’analyse du fichier journal permet d’optimiser l’architecture du site web et la structure des liens.

#4. Découverte des pages orphelines

Les pages orphelines sont des pages de votre site qui ne sont liées à aucune autre page. Elles sont difficiles à indexer et à référencer car les robots d’indexation ne les découvrent pas facilement.

Des outils comme Screaming Frog permettent d’identifier les pages orphelines. Pour résoudre ce problème, il suffit de relier ces pages aux autres pages de votre site.

#5. Audit de la vitesse et de l’expérience utilisateur de la page

L’expérience utilisateur et les Core Web Vitals sont désormais des facteurs de classement importants. Il est donc impératif que vos pages respectent les directives de Google en matière de vitesse de chargement.

Les analyseurs de fichiers journaux permettent de détecter les pages lentes ou trop lourdes. L’optimisation de la vitesse de ces pages améliorera votre classement général dans les résultats de recherche.

L’analyse des fichiers journaux vous permet de contrôler la façon dont votre site web est exploré et comment les moteurs de recherche le traitent.

Maintenant que nous avons compris les bases des fichiers journaux et leur analyse, examinons le processus d’audit des fichiers journaux pour le référencement.

Comment effectuer une analyse de fichier journal

Nous avons vu différents aspects des fichiers journaux et leur importance pour le SEO. Il est temps d’apprendre le processus d’analyse et les meilleurs outils pour cela.

Vous aurez besoin d’accéder au fichier journal du serveur de votre site web pour pouvoir analyser ces données. Voici les méthodes possibles :

L’accès manuel aux fichiers journaux comporte plusieurs étapes.

- Collectez ou exportez les données du journal à partir du serveur web et filtrez-les pour ne garder que les informations relatives aux robots des moteurs de recherche.

- Convertissez le fichier téléchargé dans un format lisible à l’aide d’outils d’analyse de données.

- Analysez manuellement les données à l’aide d’Excel ou d’autres outils de visualisation pour identifier les points faibles et les opportunités d’amélioration pour votre SEO.

- Vous pouvez également utiliser des programmes de filtrage et des lignes de commande pour faciliter la tâche.

Le traitement manuel des données de fichiers journaux est complexe, car il requiert une bonne maîtrise d’Excel et l’implication de l’équipe de développement. C’est pourquoi les outils d’analyse de fichiers journaux sont si utiles aux spécialistes SEO.

Passons en revue les meilleurs outils d’audit des fichiers journaux et comment ils facilitent l’analyse de ces données.

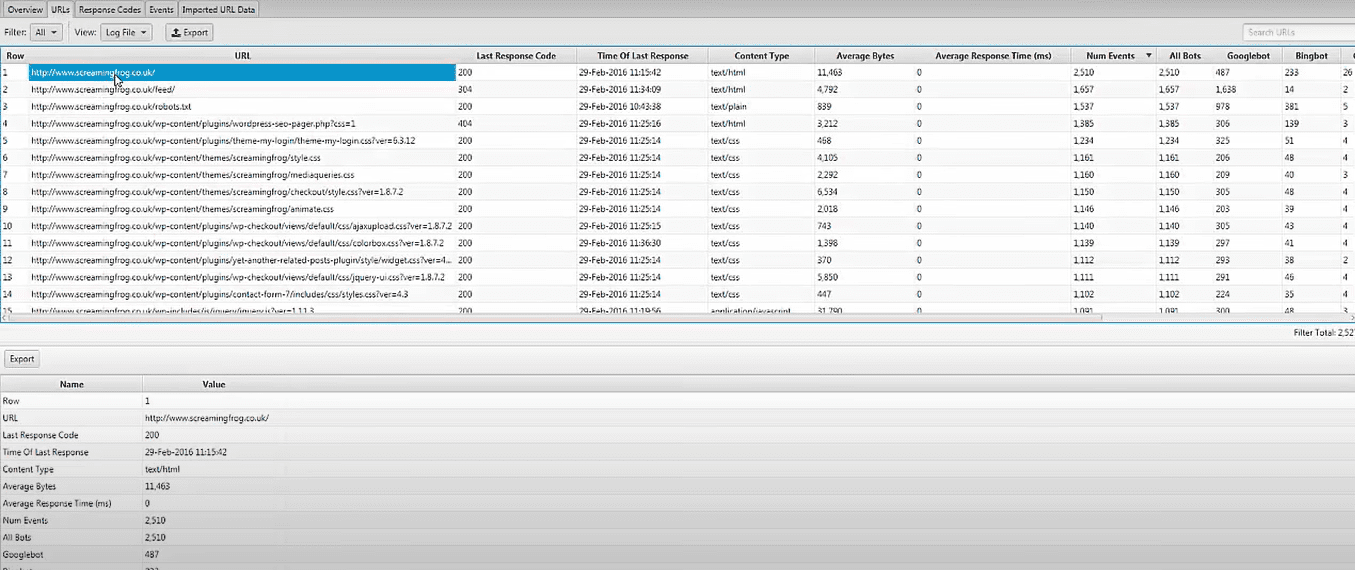

Analyseur de fichiers journaux Screaming Frog

Vous pouvez identifier les problèmes techniques SEO en téléchargeant les données de vos fichiers journaux et en vérifiant l’activité des robots d’indexation à l’aide de l’Analyseur de fichiers journaux Screaming Frog. Cet outil permet également de :

- Suivre l’activité et les données des robots d’indexation pour l’optimisation SEO.

- Découvrir la fréquence d’exploration de votre site par les robots des moteurs de recherche.

- Identifier les problèmes techniques de référencement et les liens brisés, internes ou externes.

- Analyser les URL les moins et les plus explorées pour améliorer l’efficacité de votre crawl budget.

- Découvrir les pages qui ne sont pas explorées par les moteurs de recherche.

- Comparer et combiner toutes les données, y compris les données de liens externes et d’autres informations.

- Afficher les données sur les URL référentes.

L’analyseur de fichiers journaux Screaming Frog est gratuit pour un seul projet, avec une limite de 1000 événements de journal par ligne. Vous devrez passer à la version payante pour un accès illimité et un support technique.

JetOctopus

JetOctopus est un excellent outil d’analyse de journaux abordable. Il propose un essai gratuit de sept jours sans besoin de carte de crédit. En deux clics, vous pouvez commencer à l’utiliser. Comme d’autres outils, l’analyseur de journaux JetOctopus permet d’identifier la fréquence d’exploration, le budget de crawl et les pages les plus populaires.

Cet outil vous permet d’intégrer les données de vos fichiers journaux avec celles de Google Search Console, ce qui vous donne un avantage certain sur la concurrence. Cette combinaison vous permet d’analyser l’interaction de Googlebot avec votre site et d’identifier les points d’amélioration.

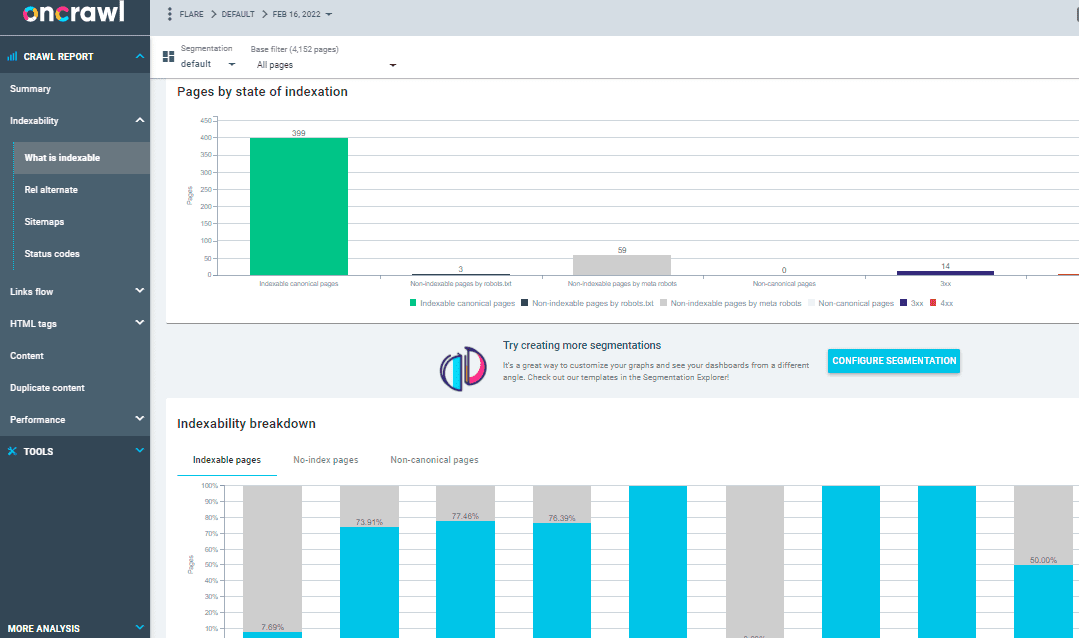

Analyseur de journaux Oncrawl

L’Analyseur de journaux Oncrawl est conçu pour les sites web de taille moyenne à grande. Il traite plus de 500 millions de lignes de log par jour. Il surveille les journaux de votre serveur web en temps réel pour garantir que vos pages sont correctement indexées et explorées.

Oncrawl Log Analyzer est conforme au RGPD et hautement sécurisé. Au lieu d’adresses IP, le programme stocke tous les fichiers journaux dans un cloud FTP sécurisé et distinct.

Outre les fonctionnalités de JetOctopus et Screaming Frog Log File Analyzer, Oncrawl propose quelques options supplémentaires :

- Il prend en charge plusieurs formats de journaux tels que IIS, Apache et Nginx.

- L’outil s’adapte facilement à vos besoins de traitement et de stockage à mesure qu’ils évoluent.

- La segmentation dynamique est un outil puissant pour identifier des tendances et des liens dans vos données. Il regroupe vos URL et liens internes en fonction de critères variés.

- Vous pouvez utiliser les données brutes de vos fichiers journaux pour créer des rapports SEO exploitables.

- Le transfert de fichiers journaux vers votre espace FTP peut être automatisé avec l’aide de votre équipe technique.

- Tous les navigateurs les plus populaires peuvent être surveillés, y compris les robots de Google, Bing, Yandex et Baidu.

OnCrawl Log Analyzer propose deux autres outils importants :

Robot d’exploration SEO Oncrawl : Avec Oncrawl SEO Crawler, vous pouvez explorer votre site web à grande vitesse et avec un minimum de ressources. Il vous permet de mieux comprendre comment les critères de classement affectent l’optimisation de vos moteurs de recherche (SEO).

Données d’exploration : Les données Oncrawl analysent tous les facteurs SEO en combinant les données d’exploration et d’analyse. Il récupère les données des analyses de fichiers journaux pour comprendre le comportement d’exploration et recommande le budget de crawl au contenu prioritaire ou aux pages de classement.

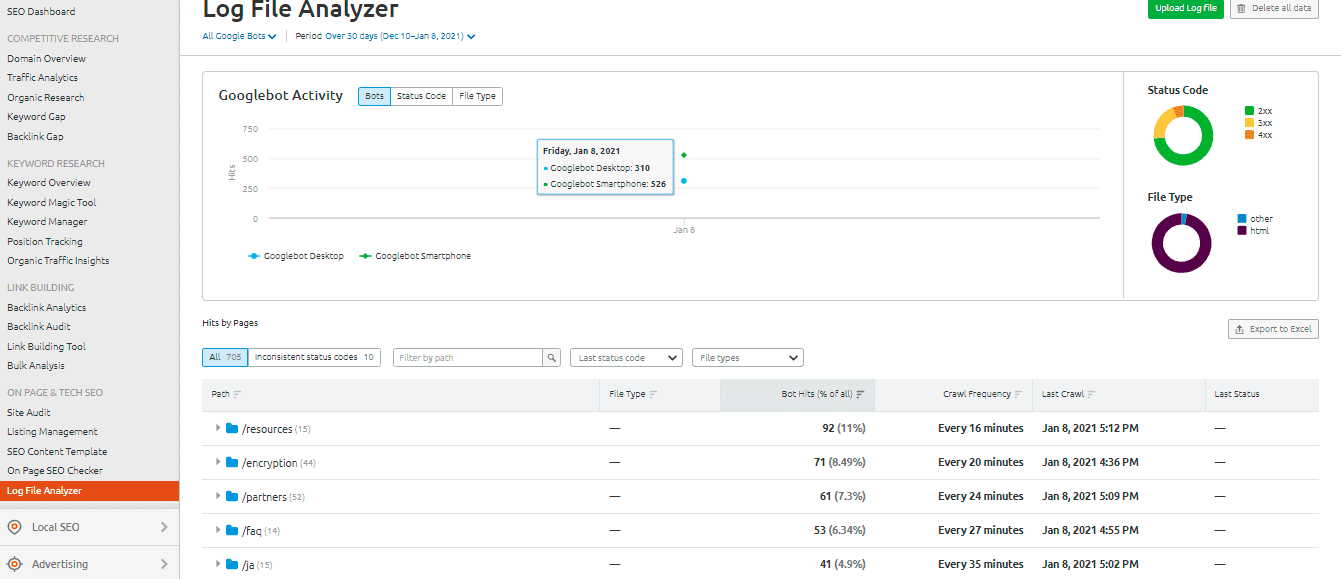

Analyseur de fichiers journaux SEMrush

L’analyseur de fichiers journaux SEMrush est un bon choix si vous cherchez un outil d’analyse simple et basé sur un navigateur. Il est utilisable directement en ligne et ne nécessite aucun téléchargement.

SEMrush vous propose deux rapports :

Accès aux pages : Ce rapport présente l’interaction des robots d’indexation avec le contenu de votre site. Il fournit des données sur les pages, dossiers et URL ayant le plus et le moins d’interactions avec les robots.

L’activité du Googlebot : Ce rapport fournit quotidiennement des informations sur votre site, telles que :

- Les types de fichiers explorés.

- Le code d’état HTTP global.

- Le nombre de requêtes effectuées sur votre site par différents robots.

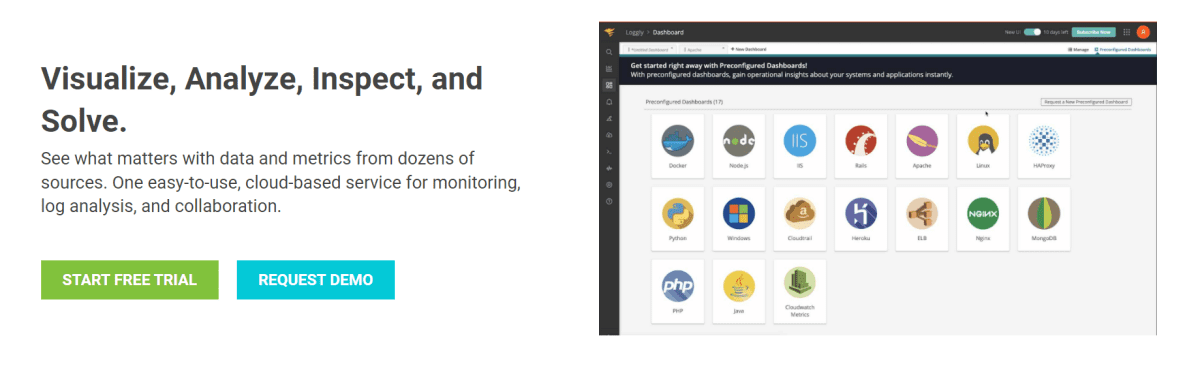

Loggly de SolarWinds

Loggly de SolarWinds analyse les journaux d’accès et d’erreurs de votre serveur web, ainsi que les statistiques hebdomadaires du site. Vous pouvez consulter vos données de journal à tout moment, et ses fonctionnalités facilitent la recherche dans les journaux.

Un outil d’analyse de fichiers journaux puissant comme SolarWinds Loggly est essentiel pour extraire efficacement les fichiers journaux de votre serveur web. Cela vous permet d’obtenir des informations précises sur les succès ou les échecs des demandes de ressources de vos clients.

Loggly peut générer des graphiques affichant les pages les moins consultées, et calculer les vitesses de chargement de page moyennes, minimales et maximales. Ceci vous permet d’optimiser le référencement de votre site.

Statistiques d’exploration de la console de recherche Google

La Console de recherche Google offre une vue d’ensemble utile de vos pratiques d’exploration. Son fonctionnement est simple. Vos statistiques d’exploration sont divisées en trois catégories :

- Kilo-octets téléchargés par jour : Cela indique le nombre de kilooctets téléchargés par les robots de Google lors de leurs visites sur votre site. Deux points importants : des moyennes élevées peuvent indiquer une exploration plus fréquente ou que les robots prennent beaucoup de temps à explorer votre site car il n’est pas optimisé.

- Pages explorées par jour : Cela indique le nombre de pages que Googlebot explore chaque jour, et l’état de l’activité d’exploration (faible, élevé ou moyen). Un faible taux d’exploration indique que Googlebot n’explore pas votre site correctement.

- Temps passé à télécharger une page (en millisecondes) : Cela indique le temps que met Googlebot pour effectuer des requêtes HTTP lors de l’exploration de votre site. Moins le robot doit passer de temps à faire des requêtes, meilleur sera le chargement de la page car l’indexation sera plus rapide.

Conclusion

J’espère que ce guide sur l’analyse des fichiers journaux et les outils utilisés pour l’audit SEO vous a été utile. L’audit des fichiers journaux est essentiel pour améliorer les aspects techniques du référencement de votre site.

Google Search Console et SEMrush Log File Analyzer sont deux options pour un outil d’analyse gratuit et basique. Pour une analyse plus approfondie de l’interaction des robots avec votre site, vous pouvez utiliser les outils d’analyse de fichiers journaux premium et gratuits comme Screaming Frog Log File Analyzer, JetOctopus ou Oncrawl Log Analyzer.

N’hésitez pas à consulter également les outils d’exploration de sites web plus avancés pour améliorer votre SEO.