Apache Hive se présente comme un système de gestion d’entrepôt de données distribué, conçu pour assurer une haute tolérance aux pannes et permettre des analyses à grande échelle.

Un entrepôt de données est, par essence, un système de gestion de l’information qui centralise d’importants volumes de données historiques issues de diverses sources. Son objectif principal est de faciliter l’analyse de ces données et la production de rapports pertinents. Cette capacité soutient l’intelligence économique, conduisant ainsi à des prises de décisions plus éclairées.

Les données traitées par Apache Hive sont habituellement stockées au sein d’Apache Hadoop, une infrastructure open source conçue pour le stockage et le traitement distribué de données. Hive s’appuie sur Hadoop pour accéder et gérer les informations qu’il contient. Cependant, il est important de noter que d’autres systèmes de stockage, comme Apache HBase, peuvent également être utilisés.

L’atout majeur d’Apache Hive réside dans sa capacité à permettre aux utilisateurs de lire, écrire et administrer des ensembles de données massifs. Il permet également d’interroger et d’analyser ces informations à l’aide du langage Hive Query Language (HQL), qui présente des similarités avec SQL.

Fonctionnement d’Apache Hive

Apache Hive offre une interface de type SQL qui simplifie l’interrogation et la gestion de vastes quantités de données hébergées dans le système de fichiers distribué Hadoop (HDFS). Lorsqu’un utilisateur lance une requête dans Hive, celle-ci est convertie en une suite de tâches MapReduce, qui sont exécutées par le cluster Hadoop.

MapReduce est un modèle de traitement qui permet de manipuler de gros volumes de données en parallèle sur un réseau distribué d’ordinateurs. Une fois les tâches MapReduce terminées, leurs résultats sont traités et combinés afin d’obtenir un unique résultat final. Ce dernier peut être stocké dans une table Hive ou exporté vers HDFS pour des analyses ou traitements ultérieurs.

Pour accélérer l’exécution des requêtes, Hive utilise un système de partitions qui divise les tables en sous-ensembles basés sur des informations spécifiques. Ces partitions peuvent être encore subdivisées, un processus appelé « bucketing », ce qui permet une interrogation très rapide des jeux de données volumineux.

Apache Hive est un outil essentiel pour les organisations qui travaillent avec le Big Data. Il permet une gestion aisée des grands ensembles de données, un traitement rapide de l’information et la réalisation d’analyses complexes de manière simplifiée. Ces capacités conduisent à la production de rapports détaillés et exhaustifs, favorisant ainsi une prise de décision améliorée.

Avantages de l’utilisation d’Apache Hive

Voici quelques-uns des bénéfices tirés de l’utilisation d’Apache Hive :

Facilité d’utilisation

L’utilisation d’HQL, qui ressemble à SQL, pour l’interrogation de données rend Apache Hive accessible aussi bien aux développeurs qu’aux utilisateurs non techniques. Cela permet d’analyser des ensembles de données massifs sans avoir à apprendre un nouveau langage ou une syntaxe particulière. Cet aspect a joué un rôle clé dans l’adoption et la popularité d’Apache Hive au sein des entreprises.

Rapidité

Apache Hive assure une analyse rapide des données, même pour les ensembles volumineux, grâce au traitement par lots. Cette méthode consiste à collecter et traiter de grandes quantités de données par groupes. Les résultats sont ensuite fusionnés pour obtenir un résultat final. Ce processus rend le traitement et l’analyse rapides et efficaces.

Fiabilité

Hive s’appuie sur le système de fichiers distribué Hadoop (HDFS) pour le stockage des données. Cette architecture permet la réplication des données lors de leur analyse, créant ainsi un environnement tolérant aux pannes où l’information est protégée même en cas de dysfonctionnement des systèmes informatiques.

Cette caractéristique confère à Apache Hive une grande fiabilité et une tolérance aux pannes supérieure à d’autres systèmes d’entrepôt de données.

Évolutivité

La conception d’Apache Hive lui permet de s’adapter et de gérer sans difficulté des ensembles de données toujours plus importants. Cela offre aux utilisateurs une solution d’entrepôt de données qui évolue en fonction de leurs besoins.

Rentabilité

En comparaison avec d’autres solutions d’entreposage de données, Apache Hive, étant open source, est plus économique à mettre en œuvre. Il représente donc une option avantageuse pour les entreprises qui souhaitent minimiser leurs coûts d’exploitation tout en restant rentables.

En résumé, Apache Hive est une solution d’entreposage de données robuste et fiable, qui s’adapte aux besoins de l’utilisateur, tout en étant rapide, économique et facile à utiliser.

Fonctionnalités d’Apache Hive

Voici les principales fonctionnalités d’Apache Hive :

#1. Serveur Hive 2 (HS2)

HS2 prend en charge l’authentification et la gestion simultanée de plusieurs clients. Il a été conçu pour une meilleure compatibilité avec les clients API ouverts tels que Java Database Connectivity (JDBC) et Open Database Connectivity (ODBC).

#2. Serveur Hive Metastore (HMS)

HMS agit comme un dépôt central pour les métadonnées des tables Hive et des partitions au sein d’une base de données relationnelle. Les métadonnées stockées dans HMS sont accessibles aux clients via l’API de service metastore.

#3. ACID de Hive

Hive assure la conformité de toutes les transactions avec les propriétés ACID, qui comprennent l’atomicité, la cohérence, l’isolation et la durabilité, garantissant ainsi l’intégrité des opérations de base de données.

#4. Compactage des données de Hive

Le compactage des données est un processus qui consiste à réduire la taille des données stockées et transmises sans nuire à leur qualité ou à leur intégrité. Cela passe par l’élimination des redondances et des données inutiles, ou par l’utilisation d’un codage spécial. Hive offre une prise en charge intégrée du compactage de données.

#5. Réplication de Hive

Hive intègre un cadre qui permet de répliquer les métadonnées et les modifications de données entre différents clusters. Cette fonction est essentielle pour créer des sauvegardes et assurer la récupération des données.

#6. Sécurité et observabilité

Hive peut être intégré à Apache Ranger, qui permet de contrôler et de gérer la sécurité des données, et à Apache Atlas, qui aide les entreprises à respecter leurs exigences de conformité. Hive prend aussi en charge l’authentification Kerberos, un protocole réseau qui sécurise les communications. Ces trois éléments assurent la sécurité et l’observabilité de Hive.

#7. Hive LLAP

Hive est doté d’un traitement analytique à faible latence (LLAP) qui optimise la mise en cache des données et utilise une infrastructure de requête persistante, rendant ainsi Hive très rapide.

#8. Optimisation basée sur les coûts

Hive emploie un optimiseur de requêtes basé sur les coûts et le framework d’exécution de requêtes Apache Calcite pour optimiser ses requêtes SQL. Apache Calcite est souvent utilisé dans la construction de bases de données et de systèmes de gestion de données.

Ces fonctionnalités font d’Apache Hive un système d’entrepôt de données performant.

Cas d’utilisation d’Apache Hive

Apache Hive est une solution polyvalente d’entrepôt et d’analyse de données qui facilite le traitement et l’analyse de grandes quantités d’informations. Voici quelques exemples de cas d’utilisation d’Apache Hive :

Analyse de données

Apache Hive permet d’analyser de vastes ensembles de données à l’aide d’instructions de type SQL. Cela permet aux organisations de détecter des tendances dans leurs données et d’en tirer des conclusions pertinentes. Des entreprises telles qu’AirBnB, FINRA et Vanguard utilisent Apache Hive pour l’analyse et l’interrogation de leurs données.

Traitement par lots

Apache Hive est également utilisé pour traiter d’importants ensembles de données par lots, grâce à un traitement distribué de l’information. Cette approche accélère le traitement des données massives. Par exemple, Guardian, une société d’assurance et de gestion de patrimoine, utilise Apache Hive à cette fin.

Entreposage de données

Apache Hive est utilisé pour stocker et gérer de très grands ensembles de données. En plus de cela, les données stockées peuvent être analysées et des rapports peuvent être générés à partir de ces données. Des entreprises telles que JPMorgan Chase et Target utilisent Apache Hive comme solution d’entrepôt de données.

Marketing et analyse client

Les organisations peuvent utiliser Apache Hive pour analyser leurs données clients, effectuer une segmentation et mieux comprendre leur clientèle. Cette compréhension permet d’ajuster les efforts marketing. C’est un cas d’usage valable pour toutes les entreprises qui gèrent des données clients.

Traitement ETL (Extraire, Transformer, Charger)

Lorsque l’on travaille avec un grand volume de données dans un entrepôt de données, il est nécessaire de procéder au nettoyage, à l’extraction et à la transformation des données avant de pouvoir les charger et les stocker.

Ce processus assure un traitement et une analyse de données rapides, efficaces et sans erreurs. Apache Hive peut effectuer toutes ces opérations avant le chargement des données dans l’entrepôt.

Ces exemples constituent les principaux cas d’utilisation d’Apache Hive.

Ressources d’apprentissage

Apache Hive est un outil précieux pour l’entreposage et l’analyse de grands ensembles de données. Les entreprises et les particuliers qui travaillent avec de grandes quantités d’informations peuvent bénéficier de l’utilisation d’Apache Hive. Pour approfondir vos connaissances sur Apache Hive, voici quelques ressources utiles :

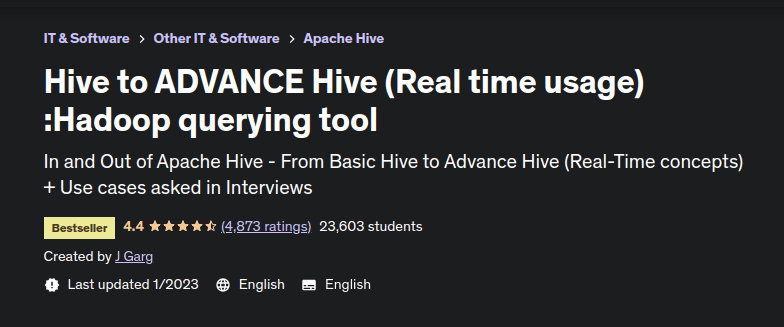

#1. Hive To ADVANCE Hive (utilisation en temps réel)

« Hive to Advance Hive » est un cours Udemy proposé par J Garg, un consultant senior en Big Data. Avec plus de dix ans d’expérience dans les technologies Apache pour l’analyse de données et la formation, J Garg partage son expertise.

Ce cours unique guide les apprenants des bases d’Apache Hive jusqu’aux concepts avancés. Il inclut également une section dédiée aux cas d’utilisation rencontrés lors d’entretiens d’embauche. Des ensembles de données et des requêtes Apache Hive sont mis à disposition pour permettre aux apprenants de pratiquer.

Les thèmes abordés incluent les fonctions avancées de Hive, les techniques de compression, les paramètres de configuration, l’utilisation de plusieurs tables, et le chargement de données non structurées.

La force de ce cours réside dans sa couverture exhaustive des concepts Hive avancés, utilisés dans des projets réels.

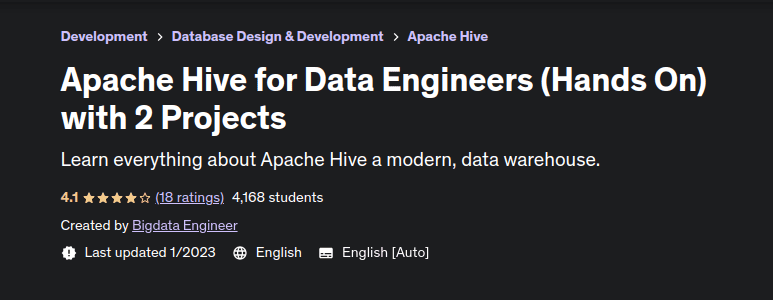

#2. Apache Hive pour les ingénieurs de données

Ce cours Udemy, axé sur la pratique à travers des projets, enseigne aux apprenants comment utiliser Apache Hive, du niveau débutant au niveau expert, en travaillant sur des cas réels.

Le cours commence par une introduction à Apache Hive et justifie son importance pour les ingénieurs de données. Il explore ensuite l’architecture de Hive, son installation et les configurations nécessaires. Une fois les bases établies, le cours couvre les flux de requêtes Hive, les fonctionnalités, les limitations et le modèle de données.

Il aborde également les types de données, le langage de définition des données, le langage de manipulation des données. Les dernières sections sont consacrées aux concepts avancés tels que les vues, le partitionnement, le bucketing, les jointures, les fonctions et les opérateurs intégrés.

Le cours se conclut avec une section sur les questions d’entretien fréquemment posées. C’est une ressource précieuse pour apprendre à utiliser Apache Hive dans des contextes concrets.

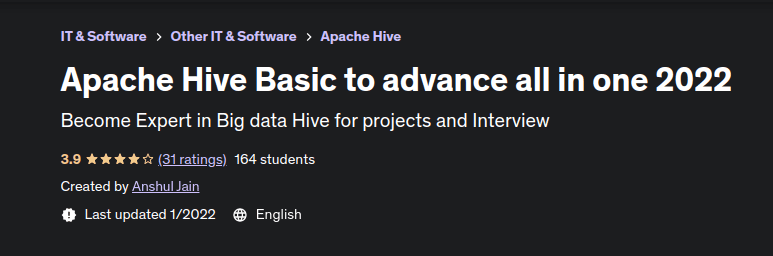

#3. Apache Hive Basic pour progresser

Ce cours est proposé par Anshul Jain, un ingénieur de données chevronné. Il s’adresse aux débutants qui souhaitent acquérir une compréhension solide d’Apache Hive.

Le cours présente les concepts d’Apache Hive d’une manière simple à comprendre et couvre les clauses HQL, les fonctions de fenêtre, la vue matérialisée, les opérations CRUD dans Hive, l’échange de partitions, et l’optimisation des performances.

Ce cours offre une expérience pratique avec Apache Hive et prépare également les apprenants aux questions d’entretien courantes dans le domaine.

#4. Les bases d’Apache Hive

Ce livre est un guide précieux pour les analystes de données, les développeurs et toute personne souhaitant apprendre à utiliser Apache Hive.

L’auteur possède plus de dix ans d’expérience dans la conception et la mise en œuvre d’architectures Big Data d’entreprise.

Le livre explique comment créer et configurer un environnement Hive, comment décrire efficacement les données avec le langage de définition de Hive, comment joindre et filtrer des ensembles de données.

Il aborde également les transformations de données, l’agrégation et l’échantillonnage, l’optimisation des requêtes et l’amélioration de la sécurité dans Hive. Enfin, il traite de la personnalisation de Hive pour répondre aux besoins spécifiques des utilisateurs.

#5. Livre de recettes Apache Hive

Ce livre, disponible en format Kindle et broché, propose une approche pratique et accessible d’Apache Hive. Il vous permet de comprendre Apache Hive et son intégration avec les frameworks Big Data.

Conçu pour les lecteurs ayant des connaissances préalables en SQL, ce livre détaille la configuration d’Apache Hive avec Hadoop, les services au sein de Hive, le modèle de données, et le langage de définition et de manipulation de données.

Il couvre également les fonctionnalités d’extensibilité, les jointures, l’optimisation, les statistiques, les fonctions, le réglage, la sécurité, et l’intégration de Hive avec d’autres frameworks.

Conclusion

Il est important de noter qu’Apache Hive est principalement adapté aux tâches d’entreposage de données traditionnelles, et moins approprié pour le traitement transactionnel en ligne. Apache Hive est conçu pour optimiser les performances, l’évolutivité, la tolérance aux pannes, et la compatibilité avec différents formats d’entrée.

Les organisations qui gèrent et traitent de grands volumes de données peuvent tirer un avantage considérable des fonctionnalités d’Apache Hive pour le stockage et l’analyse de leurs informations.

Il est également conseillé d’explorer les différences majeures entre Apache Hive et Apache Impala pour une meilleure compréhension des options disponibles.