L’Ère du Big Data et le Besoin de Traitement de Données

Avec l’expansion phénoménale d’Internet, nous sommes submergés par des téraoctets et des pétaoctets de données. L’enjeu majeur est de savoir comment exploiter ce déluge d’informations pour améliorer concrètement la disponibilité des services. Comment transformer ces masses de données brutes en informations exploitables et pertinentes ?

Pour les entreprises, la clé réside dans l’accès à des données fiables, récentes et intelligibles. C’est sur ces bases solides qu’elles peuvent bâtir des modèles de découverte de connaissances efficaces.

Dans cette optique, les entreprises font appel à diverses techniques d’analyse afin de dénicher des données de haute qualité. Cependant, tout ce processus commence par une étape cruciale : le traitement des données, ou « data wrangling ».

Explorons ce concept fondamental.

Qu’est-ce que le Data Wrangling ?

Le « data wrangling », ou traitement de données, est l’art de nettoyer, de structurer et de transformer des données brutes afin de les rendre aptes à l’analyse. Il s’agit souvent de composer avec des ensembles de données désordonnés, complexes, qui ne sont pas immédiatement utilisables pour un pipeline de données. Cette étape de traitement fait passer les données brutes vers un état affiné, voire optimisé, prêtes pour la production.

Voici quelques exemples de tâches typiques dans le traitement de données :

- Fusionner plusieurs jeux de données en une seule entité plus grande, pour l’analyse.

- Identifier et gérer les données manquantes.

- Éliminer les valeurs aberrantes ou les anomalies.

- Uniformiser les entrées.

La manipulation de grands volumes de données dépasse généralement la capacité d’un traitement manuel. Il est donc essentiel d’utiliser des méthodes automatisées de préparation afin de garantir une plus grande précision et une meilleure qualité des données.

Les Objectifs du Traitement des Données

Au-delà de la préparation des données pour l’analyse, le « data wrangling » poursuit d’autres objectifs importants :

- Transformer des données désordonnées en données fiables et pertinentes pour éclairer les décisions stratégiques des entreprises.

- Normaliser les données brutes afin qu’elles puissent être ingérées par des systèmes Big Data.

- Réduire le temps que les analystes passent à créer des modèles de données, en leur fournissant des données déjà structurées.

- Assurer la cohérence, l’exhaustivité, la convivialité et la sécurité de tous les jeux de données, qu’ils soient consommés ou stockés dans un entrepôt de données.

Les Approches Courantes du Traitement de Données

Découverte

Avant toute manipulation, les ingénieurs de données doivent comprendre la structure des données : comment elles sont stockées, leur volume, le nombre d’enregistrements, les formats d’encodage, ainsi que toute autre caractéristique pertinente.

Structuration

Cette étape consiste à organiser les données pour les rendre facilement utilisables. Les données brutes peuvent nécessiter un remaniement de la disposition des colonnes, du nombre de lignes ou d’autres attributs afin de simplifier l’analyse.

Nettoyage

Les données structurées doivent ensuite être débarrassées de toutes les erreurs et éléments qui pourraient biaiser l’interprétation des données. Le nettoyage implique de supprimer les doublons, les cellules vides, les anomalies, d’uniformiser les entrées et de renommer les attributs ambigus.

Enrichissement

Une fois la structuration et le nettoyage effectués, il est important d’évaluer la pertinence des données et de l’améliorer en ajoutant des valeurs provenant d’autres jeux de données, afin d’atteindre le niveau de qualité souhaité.

Validation

Le processus de validation est itératif et permet de s’assurer de la qualité, de la cohérence, de la convivialité et de la sécurité des données. Il garantit que toutes les transformations nécessaires ont été effectuées et atteste que les jeux de données sont prêts pour les phases d’analyse et de modélisation.

Présentation

Une fois toutes ces étapes achevées, les données traitées peuvent être diffusées au sein de l’organisation pour des fins d’analyse. La documentation des étapes de préparation et les métadonnées produites durant le processus sont également partagées à ce stade.

Talend

Talend est une plateforme de gestion de données unifiée, structurée autour de 3 « data fabrics » pour fournir des données fiables et saines. Talend intègre la gestion des données, les applications, l’intégration, l’intégrité et la gouvernance. La gestion des données sur Talend se fait via un outil intuitif, basé sur un navigateur, qui permet des préparations de données par lots, en bloc et en direct, incluant le profilage, le nettoyage et la documentation des données.

Talend Data Fabric gère chaque étape du cycle de vie des données, en veillant à un équilibre entre disponibilité, utilisabilité, sécurité et intégrité de chaque information métier.

Si vous êtes préoccupé par la diversité de vos sources de données, l’approche unifiée de Talend permet une intégration rapide depuis toutes les sources (bases de données, stockages cloud, endpoints d’API). Cela permet la transformation et le mapping des données avec des contrôles de qualité transparents.

L’intégration de données dans Talend est facilitée par des outils en libre-service, tels que des connecteurs, qui permettent aux développeurs d’ingérer automatiquement des données de n’importe quelle source et de les catégoriser de manière appropriée.

Fonctionnalités de Talend

Intégration universelle des données

Talend permet aux entreprises de gérer tous les types de données, provenant d’environnements cloud ou sur site.

Flexibilité

Talend est agnostique du fournisseur ou de la plateforme lors de la création de pipelines de données à partir de données intégrées. Les pipelines créés peuvent être exécutés n’importe où.

Qualité des données

Grâce à des fonctionnalités de machine learning, comme la déduplication, la validation et la standardisation, Talend nettoie automatiquement les données ingérées.

Prise en charge des intégrations d’applications et d’API

Une fois que le sens est donné aux données avec les outils de Talend, vous pouvez les partager via des API conviviales. Les endpoints de l’API Talend peuvent exposer vos actifs de données aux plateformes SaaS, JSON, AVRO et B2B grâce à des outils avancés de mapping et de transformation.

R

R est un langage de programmation performant et très développé, conçu pour l’analyse exploratoire de données, tant pour les applications scientifiques que commerciales.

Conçu comme un logiciel libre pour le calcul statistique et les graphiques, R est à la fois un langage et un environnement pour la manipulation, la modélisation et la visualisation des données. L’environnement R fournit une suite de progiciels, tandis que le langage R intègre des techniques statistiques, de regroupement, de classification, d’analyse et graphiques qui facilitent la manipulation des données.

Caractéristiques de R

Richesse des packages

Les ingénieurs de données ont accès à plus de 10 000 packages et extensions normalisés disponibles sur le Comprehensive R Archive Network (CRAN), ce qui simplifie le traitement et l’analyse des données.

Puissance

Grâce aux packages informatiques distribués, R est capable d’effectuer des manipulations complexes et simples (mathématiques et statistiques) sur des objets et des jeux de données en quelques secondes.

Multiplateforme

R est indépendant de la plateforme et peut fonctionner sur de nombreux systèmes d’exploitation. Il est également compatible avec d’autres langages de programmation, ce qui facilite la manipulation de tâches de calcul complexes.

L’apprentissage de R est facile.

Trifacta

Trifacta est un environnement cloud interactif dédié au profilage des données, basé sur des modèles d’apprentissage automatique et d’analyse. Cet outil d’ingénierie de données vise à rendre les données compréhensibles, quelle que soit leur complexité ou leur niveau de désordre. Les utilisateurs peuvent supprimer les entrées dupliquées et combler les cellules vides grâce à des fonctions de déduplication et de transformations linéaires.

Cet outil de gestion de données détecte les valeurs aberrantes et les données invalides dans n’importe quel jeu de données. Avec un système de glisser-déposer, les données disponibles sont classifiées et transformées de manière intelligente, grâce à des suggestions basées sur l’apprentissage automatique, afin d’accélérer la préparation des données.

La gestion des données dans Trifacta s’effectue via des profils visuels qui conviennent aussi bien au personnel non-technique qu’aux professionnels. Avec des transformations visualisées et intelligentes, Trifacta mise sur sa convivialité.

Qu’il s’agisse d’ingérer des données de « data marts », d’entrepôts de données ou de lacs de données, les utilisateurs sont protégés de la complexité de la préparation des données.

Caractéristiques de Trifacta

Intégrations cloud transparentes

Prise en charge de la préparation de données dans tout environnement cloud ou hybride, permettant aux développeurs d’ingérer des données pour le traitement, quel que soit leur emplacement.

Multiples méthodes de normalisation des données

Trifacta offre plusieurs mécanismes pour identifier des modèles dans les données et normaliser les résultats. Les ingénieurs de données peuvent choisir une normalisation par modèle, par fonction ou une combinaison des deux.

Flux de travail simple

Trifacta organise les tâches de préparation des données sous forme de flux. Un flux contient un ou plusieurs jeux de données, ainsi que leurs recettes associées (les étapes définies qui transforment les données).

Un flux permet ainsi de réduire le temps passé par les développeurs à importer, manipuler, profiler et exporter des données.

OpenRefine

OpenRefine est un outil mature et open source pour travailler avec des données désordonnées. En tant qu’outil de nettoyage de données, OpenRefine explore les jeux de données en quelques secondes, tout en appliquant des transformations complexes aux cellules pour obtenir les formats de données souhaités.

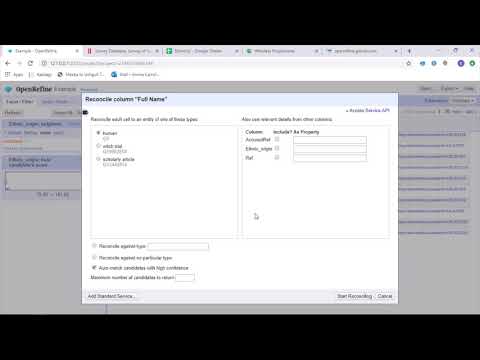

OpenRefine gère les données via des filtres et des partitions, en utilisant des expressions régulières. Grâce au langage intégré General Refine Expression Language, les ingénieurs de données peuvent analyser et afficher les données à l’aide de facettes, de filtres et de techniques de tri avant d’effectuer des opérations avancées d’extraction d’entités.

OpenRefine permet aux utilisateurs de travailler sur des données sous forme de projets où des ensembles de données provenant de multiples fichiers informatiques, d’URL web et de bases de données peuvent être extraits avec la possibilité d’être exécutés localement.

Grâce aux expressions, les développeurs peuvent étendre les possibilités de nettoyage et de transformation de données à des tâches telles que la division ou la fusion de cellules contenant plusieurs valeurs, la personnalisation de facettes et la récupération de données dans des colonnes à l’aide d’URL externes.

Fonctionnalités d’OpenRefine

Outil multiplateforme

OpenRefine est conçu pour fonctionner sur les systèmes d’exploitation Windows, Mac et Linux via des configurations d’installation téléchargeables.

Richesse des API

Comprend l’API OpenRefine, l’API d’extension de données, l’API de réconciliation et d’autres API qui prennent en charge l’interaction des utilisateurs avec les données.

Datameer

Datameer est un outil SaaS de transformation de données conçu pour simplifier la gestion et l’intégration des données via des processus d’ingénierie logicielle. Datameer permet l’extraction, la transformation et le chargement de jeux de données vers des entrepôts de données Cloud tels que Snowflake.

Cet outil de gestion de données fonctionne bien avec les formats standard, comme CSV et JSON, ce qui permet aux ingénieurs d’importer des données de formats variés pour l’agrégation.

Datameer propose une documentation de données de type catalogue, un profilage approfondi des données et une fonction de découverte pour répondre à tous les besoins de transformation. L’outil conserve un profil de données visuel détaillé qui permet aux utilisateurs de suivre les champs et les valeurs invalides, manquantes ou périphériques, ainsi que la forme générale des données.

S’appuyant sur un entrepôt de données évolutif, Datameer transforme les données pour une analyse pertinente, grâce à des piles de données efficaces et à des fonctions de type Excel.

Datameer présente une interface utilisateur hybride, avec et sans code, pour permettre à de vastes équipes d’analyse de données de créer facilement des pipelines ETL complexes.

Fonctionnalités de Datameer

Environnements multi-utilisateurs

Inclut des environnements de transformation de données multi-utilisateurs : low code, code et hybride, pour s’adapter aux profils techniques comme non-techniques.

Espaces de travail partagés

Datameer permet aux équipes de réutiliser et de collaborer sur des modèles afin d’accélérer les projets.

Documentation riche en données

Datameer prend en charge la documentation des données générées par le système et par l’utilisateur via des métadonnées, des descriptions, des balises et des commentaires de type wiki.

En conclusion 👩🏫

L’analyse de données est un processus complexe, qui exige que les données soient correctement organisées afin de tirer des conclusions significatives et de faire des prédictions fiables. Les outils de « data wrangling » vous aident à mettre en forme de grands volumes de données brutes afin de faciliter les analyses avancées. Choisissez l’outil qui répond le mieux à vos besoins et devenez un expert en analyse !

Vous pourriez également être intéressé par :

Les meilleurs outils CSV pour convertir, formater et valider.