Souhaitez-vous concevoir vos propres applications d’intelligence artificielle générative ? Voici une sélection de modèles d’IA pour vous aider à démarrer votre projet.

Les modèles d’IA sont des architectures de réseaux neuronaux qui excellent dans des tâches bien précises. Cela inclut des architectures de réseaux neuronaux convolutifs pour la classification et la segmentation d’images, des modèles de langage étendus génératifs pré-entraînés, des modèles de diffusion pour la génération d’images et bien d’autres.

Récemment, les modèles d’IA pour les applications d’IA générative (pour les images, la parole, le texte, etc.) ont gagné en popularité. Cette tendance est due aux progrès de la recherche et à l’accessibilité accrue aux ressources de calcul haute performance.

Voici un bref aperçu des modèles d’IA populaires que nous allons explorer plus en détail.

| Modèle | Capacités clés |

| GPT-4 | Modèle de langage étendu puissant, idéal pour la création d’applications basées sur LLM |

| Llama | Polyvalence en traitement du langage naturel, des chatbots aux assistants de codage |

| Falcon | Autre modèle de langage étendu open source pour le développement d’applications LLM |

| Stable Diffusion | Conversion de texte en image, remplissage, extension et mise à l’échelle d’images |

| DALL-E2 | Génération d’images à partir de texte |

| Whisper | Reconnaissance vocale, traduction linguistique et identification de langue |

| StableLM | Modèle de langage étendu open source, léger et performant |

| CLIP | Diverses tâches de PNL, comme la réponse à des questions, la synthèse et la génération de texte |

| InternLM | Modèle de langage étendu open source; adaptable à la création d’applications LLM |

| Segment Anything Model | Segmentation d’images polyvalente avec généralisation zéro-shot |

| WaveGAN | Génération audio réaliste |

| CycleGAN et pix2pix | Traduction d’image à image |

| BioGPT | Génération et analyse de textes biomédicaux |

De la création d’art par IA à la conception d’un assistant de codage sur mesure, vous pouvez développer une variété d’applications d’IA générative en fonction de vos centres d’intérêt. Nous vous présentons ici quelques modèles d’IA notables que vous pouvez explorer, ainsi que leurs principales fonctionnalités.

C’est parti !

GPT-4

Que ce soit pour organiser des itinéraires de voyage ou rédiger des lettres de motivation ciblées, ChatGPT fait désormais partie intégrante de notre quotidien. GPT-4, son successeur, est un modèle de langage étendu encore plus performant.

Il s’agit du système d’IA le plus sophistiqué d’OpenAI, doté de meilleures capacités de raisonnement et de performances supérieures à ChatGPT.

Voici un aperçu technique du fonctionnement de GPT-4 et de la manière dont vous pouvez concevoir des applications avec.

Vous pouvez accéder à l’interface ChatGPT via un compte OpenAI gratuit. Cependant, pour utiliser GPT-4, un abonnement ChatGPT Plus est nécessaire.

Voici quelques exemples d’applications que vous pouvez créer avec ces modèles de langage étendu :

- Chatbots personnalisés

- Amélioration des plateformes CRM

- Systèmes de questions-réponses basés sur des corpus de données spécifiques

- Autres tâches comme la synthèse et la génération de textes

Nous allons maintenant explorer quelques modèles de langage étendu open source.

Llama

Meta AI a lancé Llama, un modèle de langage fondamental avec 65 milliards de paramètres, en février 2023. Plus tard, Llama 2 a été introduit avec des améliorations significatives par rapport à la version précédente. Voici ce qui est accessible :

- Llama Chat : Llama 2 affiné

- Code Llama : Basé sur Llama 2 ; entraîné sur plus de 500 milliards de jetons de code ; prend en charge la génération de code dans de nombreux langages de programmation populaires.

Vous pouvez télécharger et utiliser les modèles Llama en faisant une demande d’accès. Consultez ce tutoriel pour savoir comment utiliser Llama 2 dans vos applications Python :

Falcon

Falcon est un autre modèle de langage open source créé par le Technology Innovation Institute (EAU). Tous les modèles de la suite Falcon LLM sont open source et librement accessibles. Vous pouvez donc les utiliser pour développer des applications basées sur LLM.

Il existe actuellement quatre tailles de modèles : 1,3B, 7,5B, 40B et 180B. Le modèle 180B, qui surpasse plusieurs benchmarks, a été entraîné sur un ensemble de données de 3,5T de jetons. Le Falcon LLM rivalise avec les autres LLM open source de premier plan.

Le LLM open source Falcon 180B atteint des performances comparables à celles de GPT-4. Voici un guide qui explore le Falcon 180B, son utilisation, les exigences matérielles et sa comparaison avec GPT-4 :

Stable Diffusion

Stable Diffusion est un modèle de conversion de texte en image pour la génération d’images et d’autres applications créatives d’IA. Il permet également la mise à l’échelle et le remplissage d’images.

Stable Diffusion XL, lancée en juillet 2023, offre plusieurs améliorations, notamment :

- La création d’images descriptives à partir d’invites plus courtes

- La génération de texte de support dans les images

- Les tâches de remplissage et d’extension d’images

- L’interaction avec une image source pour générer des variations

Si vous voulez comprendre le fonctionnement des modèles de diffusion (le mécanisme derrière la magie), consultez Comment fonctionnent les modèles de diffusion, un cours gratuit de DeepLearning.AI.

DALL-E2

DALL-E2 d’OpenAI est un autre modèle populaire pour la conversion de texte en image. Vous pouvez l’utiliser pour générer des images et des illustrations réalistes à partir d’une description textuelle en langage naturel.

Il peut être utilisé pour les tâches suivantes :

- Génération d’images à partir d’invites textuelles

- Remplissage et extension d’images

- Génération de variations d’une image

Vous pouvez accéder à DALL-E 2 via l’API OpenAI ou l’interface web d’OpenAI Labs.

Whisper

Whisper, d’OpenAI, est un modèle de reconnaissance vocale polyvalent, adapté à de nombreuses applications, notamment :

- L’identification de la langue

- Les tâches de reconnaissance vocale telles que la transcription de fichiers audio

- La traduction de la parole

Voici un guide sur la conversion de la parole en texte à l’aide de l’API OpenAI Whisper :

Pour tester le modèle, vous pouvez installer whisper (openai-whisper) via pip et accéder à l’API depuis un script Python pour transcrire des fichiers audio. De plus, vous pouvez utiliser d’autres modèles de langage étendu pour synthétiser la transcription et créer un pipeline audio vers résumé.

StableLM

StableLM est une suite de LLM open source de Stability AI. Les paramètres 3B et 7B sont disponibles actuellement. Les versions ultérieures proposeront des modèles plus grands avec des paramètres de 15 à 65 milliards.

Si vous souhaitez expérimenter des LLM open source et légers dans vos applications, vous pouvez essayer StableLM.

CLIP

CLIP est l’acronyme de Contrastive Language–Image Pre-training. Il s’agit d’un réseau neuronal multimodal, formé sur un vaste ensemble de données de paires (texte, image). Le modèle utilise des données en langage naturel et tente d’apprendre la sémantique des images à partir de descriptions en langage naturel. Le modèle CLIP peut prédire le texte le plus pertinent pour une image.

Avec CLIP, vous pouvez effectuer une classification d’images sans tir zéro, sans pré-entraînement ni ajustement coûteux. De plus, vous pouvez exploiter les fonctionnalités de CLIP et des bases de données vectorielles pour développer des applications intéressantes dans :

- La recherche texte-image et image-image

- La recherche d’images inversée

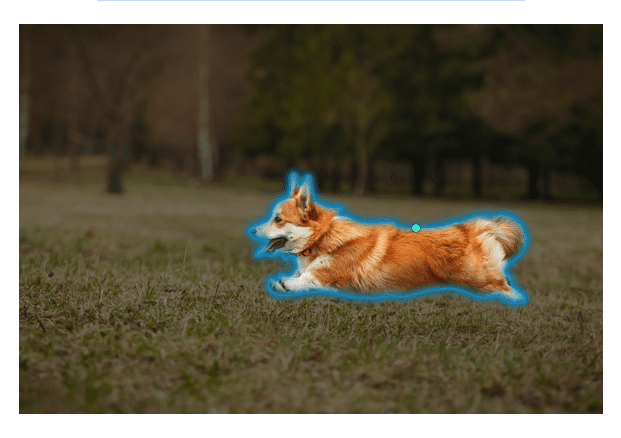

Segment Anything Model

La segmentation d’image consiste à identifier les pixels appartenant à un objet spécifique dans une image. Meta AI a lancé le Segment Anything Model (SAM) qui peut être utilisé pour segmenter n’importe quelle image et découper des objets.

Source des images : Segment Anything

Source des images : Segment Anything

Vous pouvez utiliser des invites pour définir les éléments à segmenter dans une image. Actuellement, SAM prend en charge les invites suivantes : les cadres de délimitation, les masques, ainsi que les points de premier plan et d’arrière-plan. Le modèle offre également d’excellentes performances de généralisation zéro-shot sur des images inédites. Par conséquent, aucune formation spécifique n’est requise.

Essayez le modèle SAM dans votre navigateur !

InternLM

InternLM est un modèle de langage open source. Vous pouvez essayer le modèle de base 7B et le modèle de chat open source. Le modèle prend en charge une fenêtre contextuelle de 8K. De plus, InternLM prend en charge les capacités d’interpréteur de code et d’appel de fonctions.

InternLM est également accessible via la bibliothèque de transformateurs HuggingFace. Vous pouvez utiliser le cadre léger de pré-entraînement. Il prend également en charge la création et le déploiement d’applications via LMDeploy. Vous pouvez ainsi concevoir des applications de PNL générative de bout en bout avec InternLM.

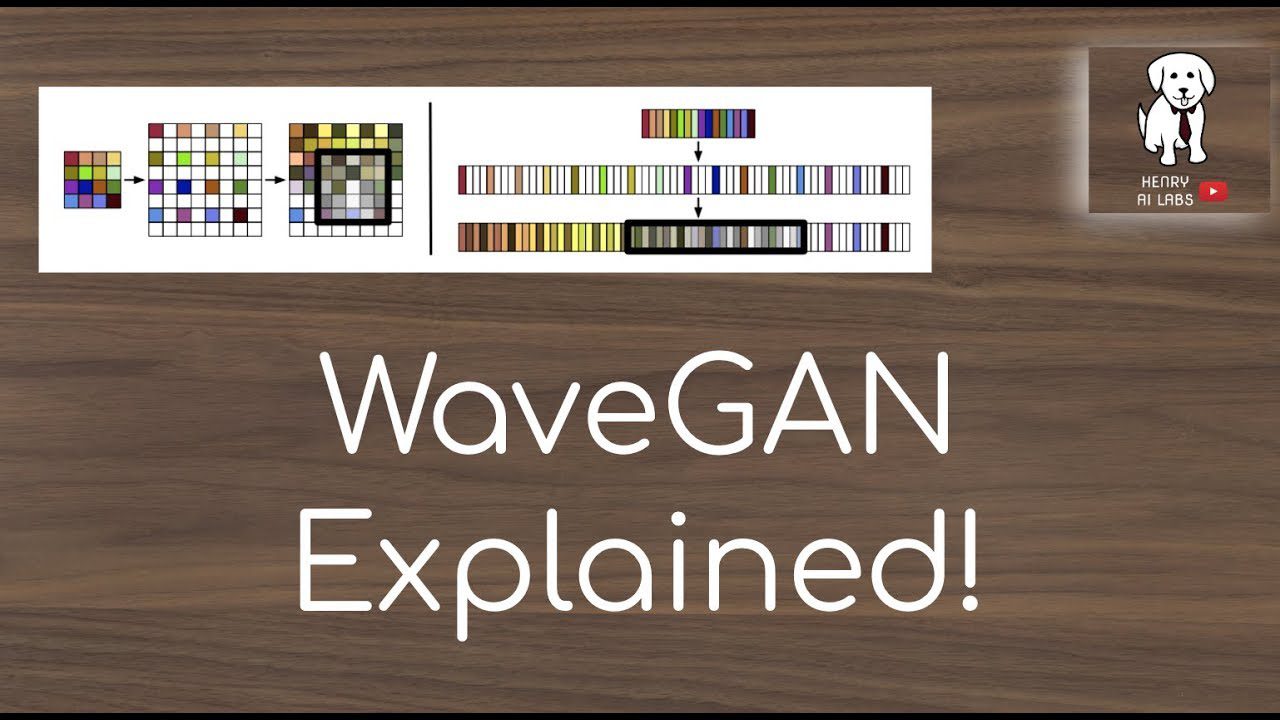

WaveGAN

WaveGAN est un modèle de génération audio. Il permet de synthétiser l’audio brut à partir d’exemples de données audio réelles.

Vous pouvez entraîner WaveGAN sur un ensemble de données de fichiers audio arbitraires et générer de l’audio sans pré-traitement avancé.

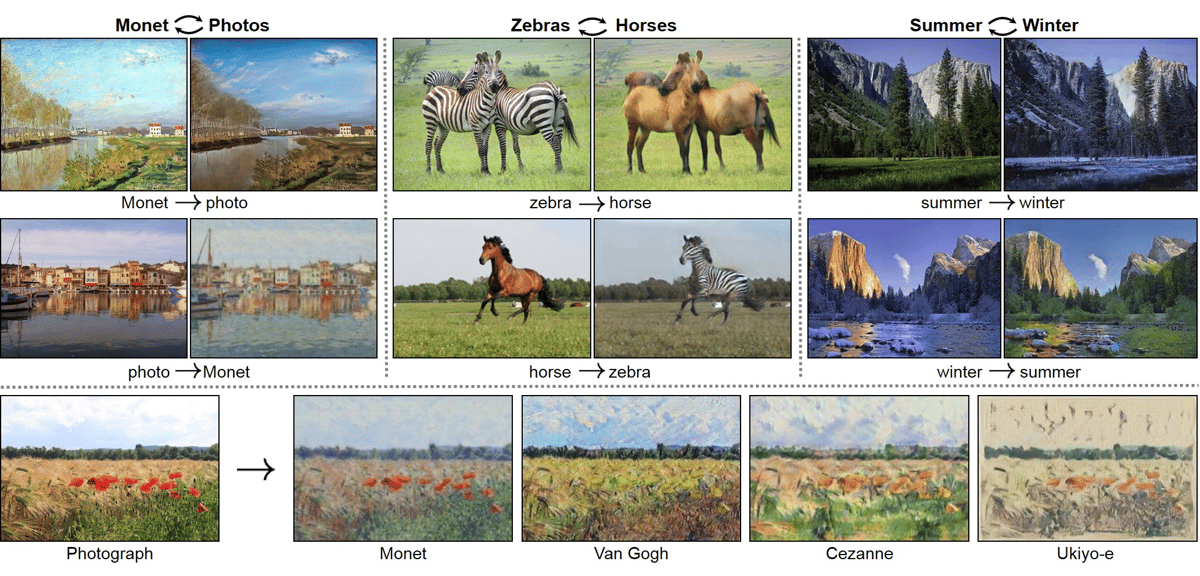

CycleGAN et Pix2Pix

Jusqu’à présent, nous avons abordé la conversion de la parole en texte, de texte en image et d’autres modèles pour diverses tâches de traitement du langage naturel. Mais que faire si vous souhaitez effectuer une traduction d’image à image ? Dans ce cas, vous pouvez utiliser CycleGAN pour apprendre un mappage du domaine source vers le domaine cible afin de réaliser une traduction d’image à image.

Par exemple, si vous avez une photo d’un lac en hiver, vous pouvez traduire cette même image pour obtenir une version estivale. De même, à partir de l’image d’un cheval, vous pouvez le remplacer par un zèbre tout en conservant le même arrière-plan. CycleGAN est bien adapté à ces tâches.

Le modèle pix2pix peut également être utilisé pour la traduction d’image à image ; les capacités clés de ce modèle sont les suivantes :

- Reconstruire des objets à partir de cartes de contour

- Coloriser des images

Vous trouverez des implémentations PyTorch de CycleGAN et pix2pix sur GitHub.

BioGPT

BioGPT de Microsoft est un modèle transformateur que vous pouvez utiliser pour les applications d’exploration de données et de génération de texte biomédical. Il utilise les implémentations de modèles séquence à séquence fournies par fairseq.

Fairseq, développé par Facebook Research (maintenant Meta AI), est un outil qui fournit des implémentations de modèles séquence à séquence pour des tâches telles que :

- La modélisation du langage

- La traduction

- La synthèse

Les deux modèles pré-entraînés et les points de contrôle des modèles affinés sont disponibles. Vous pouvez télécharger le modèle soit à partir de l’URL, soit du hub HuggingFace.

Les modèles BioGPT font également partie de la bibliothèque de transformateurs HuggingFace. Si vous travaillez dans le domaine biomédical, vous pouvez utiliser BioGPT pour créer des applications spécifiques à ce domaine.

En résumé

J’espère que vous avez découvert des modèles intéressants pour la création d’applications d’IA générative. Bien que cette liste ne soit pas exhaustive, nous avons présenté certains des modèles les plus populaires que vous pouvez utiliser pour concevoir des applications de génération de texte et d’audio, de transcription de la parole en texte, de recherche d’images, etc.

Lorsque vous développez des applications avec des modèles de langage étendus, vous devez être conscient des écueils courants, tels que les informations factuellement incorrectes et les hallucinations. Vous pouvez également rencontrer des limitations lors du réglage fin des modèles, car le processus de réglage fin est souvent gourmand en ressources.

Si vous êtes développeur, il est temps de rejoindre la révolution de l’IA et de commencer à créer des applications d’IA passionnantes ! Vous pouvez tester ces modèles dans Google Colab ou d’autres notebooks collaboratifs de science des données.